Benutzer-Werkzeuge

se:multimedia

**Dies ist eine alte Version des Dokuments!**

Inhaltsverzeichnis

Multimedia

Lernziele

- die physiognomischen Eigenheiten von Hören und Sehen kennen

- den Aufbau analoger Fernsehübertragungstechnik kennen

- das analoge Fernsehsignal in seinen Grundzügen nachvollziehen

- die Motivation der digitalen Signalverarbeitung nachvollziehen

- Methoden und Begriffe der Digitalisierung analoger Signale kennen

- wichtige Begriffe der Datenkompression und Datencodierung kennen

- verlustfreie und verlustbehaftete Kompressionsmethoden kennen

- die Verarbeitungsschritte des JPEG-Encoders kennen

- Verfahren der Interframe- und Intraframecodierung kennen

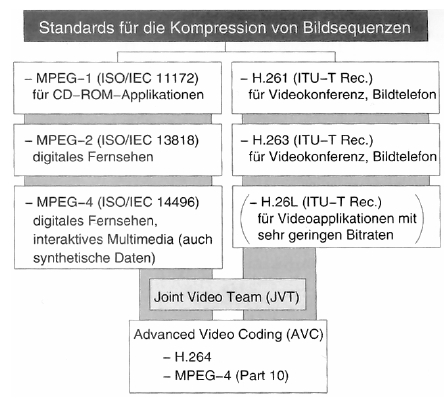

- die Evolutionsstufen der MPEG-Familie kennen

- die in MPEG verwendeten Kompressionsalgorithmen kennen

- den Aufbau des MPEG-Bilddatenstroms sowie Level und Profile kennen

- die Audiokompressionsverfahren der MPEG-Familie kennen

- die Anwendung psychoakustischer Erkenntnisse bei MPEG nachvollziehen

Einleitung

- Kommunikation ist die zielgerichtete, kanalgebundene Übertragung von Informationen von einem Sender zu einem oder mehreren Empfängern.

- Kommunikationskanäle zwischen Menschen

- textuell (Wort und Schrift)

- visuell (Licht und Farbe)

- auditiv (Ton, Klang, Sprache)

- taktil (Fühlen von Kräften, Texturen, Temperaturen)

- olfaktorisch (Riechen und Schmecken)

- Wahrnehmung von Bewegung und Beschleunigung

- im Zentrum von Multimedia stehen Menschen und ihre Wege, mit anderen Menschen und ihrer Umwelt zu kommunizieren

- Multimedia ist der Trend, die Kanäle, über die Menschen mit ihrer Umwelt kommunizieren, mit Mitteln der Informationswissenschaft über alle Quellen zu integrieren und als Gesamtheit für die Kommunikation zu nutzen.

- Multimedia-Kanäle: Text, Bild, Film/Video, Internet, Virtual Reality, Audio

Wahrnehmung

Hören

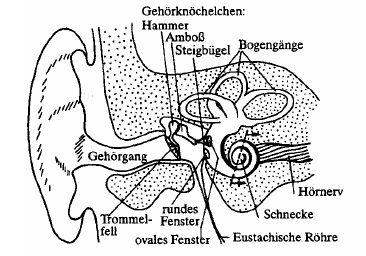

- akustische Phänomene, die das Gehör wahrnimmt, sind Kompressionen und Verdünnungen der Luftmoleküle

- die Druckwellen treffen auf das Trommelfell und werden über die Ohrknöchelchen an die Cochlea übermittelt

- feine Flimmerhärchen in der mit Lymphflüssigkeit gefüllten Cochlea schwingen und geben elektrische Impulse ans Gehirn weiter

- das menschliche Gehör kann Schallereignisse im Bereich von 18 Hz bis 20.000 Hz wahrnehmen

- Töne tiefer Frequenz benötigen einen höheren Schalldruck, um wahrgenommen zu werden → Hörschwelle

- Schmerzschwelle: Schalldruck, ab dem die Rezeption zu Schmerzempfinden führt

- Hörfeld: Bereich zwischen Hörschwelle und Schmerzschwelle

- Einheiten

- physikalisch: Dezibel als (logarithmische) Einheit für den Schalldruck → menschliche Wahrnehmung ist nicht linear zur Frequenz

- phsychoakustisch: Phon als Einheit für die Lautstärke (Lautstärkeempfinden von Frequenzen im Bezug auf den 1kHz-Sinuston) → kein quantitativer Vergleich von Lautstärken möglich, da Lautstärkeempfinden nicht proportional zu den Phon-Werten ist

- Sone (N) als Einheit für die (subjektive!) Lautheit (qualitativer Vergleich von Klangereignissen), 1 sone = 40 Phon

- Umrechnung: N = 2(LN - 40) / 10

- Psychoakustik: Teilgebiet der Psychophysik, das versucht, die Zusammenhänge zwischen physikalischen Eigenschaften von Schallsignalen und dem menschlichen Hörempfinden zu beschreiben

- psychoakustische Phänomene

- tonale Maskierung: schmalbandiger Schall einer bestimmten Intensität löscht Frequenzen geringerer Lautstärke in seinem Frequenzumfeld aus (Mithörschwelle: Grenze, ab der der Ton wahrgenommen wird), Effekt ist abhängig von Frequenz und Schallpegel des Maskierers

- temporale Maskierung (Vor- und Nachverdeckung): Maskierung vor (20ms) und nach (200ms) Auftreten des Maskierers

- Schwebung und Rauhigkeit: zwei Töne ähnlicher Frequenz werden als ein Ton bestimmter Tonhöhe wahrgenommen, wobei der Schall durch die Phasenverschiebung eine Schwebung erfährt

- je größer die Frequenzdifferenz, umso rauher klingt der Ton, bishin zur Wahrnehmung zweier unterschiedlicher Töne

- Residuum: Töne von Instrumenten setzen sich aus Grundton und Obertönen (Harmonische, Frequenzen sind ganzzahlige Vielfache des Grundtons) zusammen, filtert man den Grundton heraus, vervollständigt das menschliche Gehör die fehlende(n) Grundschwingung(en) zum ursprünglichen Klangbild

- kritische Bänder: Schallereignisse werden in Frequenzgruppen wahrgenommen, deren Gruppenbreite mit steigender Frequenz zunimmt

Sehen

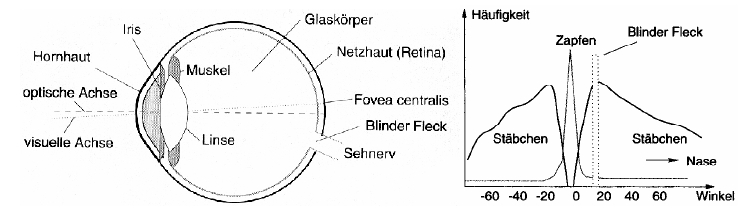

- Licht fällt durch die Hornhaus, Iris und Linse auf die Netzhaut (Retina)

- Rezeptoren auf der Retina wandeln die Lichtinformationen in elektrische Impulse

- Zapfen: farb-/helligkeitsempfindlich, 3 Typen: A grün, B gelb-rot, C violett, arbeiten bei Tageslicht optimal, Anzahl 6 Millionen

- Stäbchen: nur helligkeitsempfindlich, empfindlicher als Zapfen, Anzahl 120 Millionen

- fovea centralis: Punkt größter Sehschärfe, hier sind nur Zapfen vorhanden

- wahrnehmbares Licht: 780nm (rot) - 390nm (violett)

- blinder Fleck: hier bündeln sich die Nervenbahnen des Auges zum Sehnerv

- Gehirn verarbeitet Informationen und erzeugt ein Bild, blinder Fleck wird interpoliert, Farbinformationen werden gemischt, unterschiedliche Bilder der zwei Augen ermöglichen räumliches Sehen

- das Auflösungsvermögen des Auges ist biologisch begrenzt

- bestimmte Detailtiefe wird nicht mehr wahrgenommen

- ruhende Objekte werden besser erfasst als sich bewegende

- Helligkeitsunterschiede werden besser erfasst als Farbunterschiede

- maximale Farbempfindlichkeit bei gelb-grün

- 20 Bilder pro Sekunde werden bereits als kontinuierliche Bildfolge wahrgenommen

Analoge Fernsehtechnik

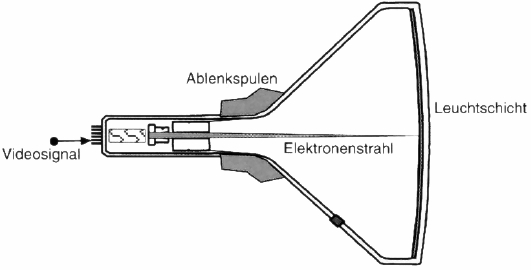

- Elektronen werden durch Magnetspulen abgelenkt und bringen auf einer Mattscheibe ein fluoreszierendes Material zum Leuchten

- Elektronenstrahl läuft zeilenweise über das Bild, Nachleuchten der Fluoreszenzschicht vermittelt Eindruck eines Bildes

- inverse Funktionsweise kann für Kameras verwendet werden

- Erkenntnisse über das Auflösungsvermögen des Auges führten zu einer Zahl von mindestens 600 Zeilen pro Bild

- alle Zeilen nacheinander abzuarbeiten (progressive, 25 Vollbilder) führt zu Flimmern → interlaced mode (50 Halbbilder)

- Parameter von PAL

- 625 Zeilen, 576 sichtbar

- Vertikalfrequenz: 50Hz, Bilddauer 20ms

- Horizontalfrequenz: 50 * 312,5 = 15625Hz, Zeilendauer 64 Mikrosekunden

- YUV Farbmodell

- Signalübertragung

- Bild-Austastung-Synchronisation (BAS)

- Bildsignal: analoge Grauwertübertragung einer Bildzeile, Signalbereich 0,7 Volt

- Austastungssignal: Signal beim Strahlenrücklauf (horizontal vs. vertikal), Pegel unter Schwarzbereich, in Austastlücke werden Metainformationen übertragen (VPS, Videotext, Prüfsignale)

- Synchronisationssignal: dient der Synchronisation jeder Bildzeile/Halbbild, Übertragung in der Austastlücke

- Farbsysteme

- additiv: selbstleuchtende Farben (z.B. Fernseh-/Computerbildschirme), RGB, alle Farben zusammen ergeben weiß

- subtraktiv: beleuchtete Träger (z.B. Offsetdruck), CMYK, alle Farben zusammen ergeben schwarz

- Farbfernsehen: PAL → YUV-Modell (Y = Helligkeit/Luminanz, UV = Farbdifferenz/Chrominanz)

- Y = 0,299R + 0,587G + 0,114B

- U = (B - Y) * 0,493

- V = (R - Y) * 0,877

- gelb-grün-Anteil trägt wesentlich zum Helligkeitsempfinden bei

- Kameras enthalten Rot-, Grün- und Blaufilter

- Farbmonitore enthalten drei Elektronenquellen

- BAS → FBAS (F = Farbe): Übertragung der Fardifferenzen in der Austastlücke

- Fernsehstandards

- NTSC (National Television Systems Committee): 720x485x30, YiQ Farbmodell

- PAL (Phase Alternating Line): 720x576x25, YUV Farbmodell

- SECAM (sequentiel couleur a memoire): Abwandlung von PAL, YiQ Farbmodell

Digitalisierung

- bis in die 90er Jahre wurden mediale Inhalte hautpsächlich analog produziert und rezipiert (Schallplatten, Musikkassette, VHS)

- Unterschiede analog/digital

- kontinuierliche, analoge Signale <> diskontinuierliche, diskrete Signale

- Generationsverlust <> kein Generationsverlust

- Störanfälligkeit im Übertragungskanal <> binäre Übertragung

- Vorteile der Digitalisierung

- Computer arbeiten digital

- die Bearbeitung und Verarbeitung von Medien in digitaler Form ist einfacher

- Datenkompression ist in digitalen Formaten einfacher zu realisieren

- Fehlerschutz- und -korrekturmechanismen sind möglich

- Kopien sind ohne Generationsverlust durchführbar (entscheidender Punkt!)

- Digitalisierung von Audioinhalten

- liegen als kontinuierliche, analoge, elektrische Signale vor → unendlich viele Werte beliebiger genauer Auflösung

- Abtastung zu bestimmten Zeitpunkten und Überführung in diskreten Wertebereich → Digitalisierung

- Abtast-/Samplingrate: Frequenz, mit der Werte im Signal abgetastet werden

- Shannon-Nyquist-Theorem: fa > 2 * fmaxHz

- wird das SNT missachtet kann das Ausgangssignal nach der Digitalisierung nicht mehr eindeutig rekonstruiert werden

- menschliches Gehör kann bis zu 20kHz wahrnehmen → Abtastrate > 40kHz

- Quantisierung: Überführung der kontinuierlichen Amplitudenwerte eines Signals in diskrete Werte

- Auflösung in bit legt die Anzahl der zulässigen Werte fest

- Quantisierungsfehler wird umso größer, je geringer die Auflösung ist → bei Audio als Rauschen hörbar

- Signal to Noise Ratio (SNR): SNR = 20 * log (ASignal / ARauschen) dB

- jedes zusätzliche Bit in der Quantisierungsauflösung resultiert in einer Erhöhung der Klangdynamik um 6dB bei gleichzeitiger Reduzierung des Rauschens um 6dB

- Pulse Code Modulation (PCM): linear = gleichmäßige Quantisierungsstufen, nicht-linear = logarithmische Quantisierungsstufen → geringere Auflösung im unteren Wertebereich

- CD-Audio: Abtastrate 44kHz, Auflösung 16bit

- Digitalisierung von Bildinhalten

- Zerlegung des Bildes in Raster bestimmter Auflösung, zeilenweise Abtastung

- Auflösung: Anzahl Zeilen und Bildpunkte pro Zeile

- Quantisierung: Anzahl der Graustufen pro Pixel

Datenkompression

- Ablauf

- ein Signal x wird durch einen Encoder in ein komprimiertes Signal y gewandelt und durch den Übertragungskanal geschickt

- der Empfänger ermittelt mit Hilfe eines Decoders das Ausgangssignal x'

- bei verlustloser Kompression werden redundante Informationen gelöscht (Entropiekodierung) und x' entspricht genau x

- bei verlustbehafteter Kompression werden irrelevante Informationen gelöscht und x' ist nicht gleich x

- Anforderungen an Kompressionsverfahren

- minimale Anzahl an bits

- Eindeutigkeit / Rekonstruierbarkeit

- kleinstmöglicher Unterschied zwischen Eingangs- und Ausgangssignal

- Kategorien: Entropiecodierung / Quellencodierung

- Reduktion redundanter Daten <> Reduktion irrelevanter Daten

- universell <> an zu komprimierenden Datenstrom angepasst

- verlustfrei <> verlustbehaftet

- Entropiecodierung: Verfahren, bei denen Auftrittswahrscheinlichkeiten zwischen verschiedenen unabhängigen Symbolen eines Alphabets zur Reduktion der Datenmenge ausgenutzt werden

- Informationsgehalt eines Zeichens: Ii = log (1 / pi) bit

- Entropie: mittlerer Informationsgehalt, Summe der Produkte aus Wahrscheinlichkeiten und Informationsgehalten aller Symbole

- statistische Codierungsverfahren versuchen, dem Wert H für die Entropie möglichst nahe zu kommen, Symbole mit hoher Wahrscheinlichkeit bekommen kürzere Codewörter zugewiesen

- Problem bei Codewörtern ungleicher Länge: Trennzeichen sind nötig oder Verwendung von Prefix-Codes

- Huffman-Code als Beispiel für Prefix-Codes

- Präcodierung: betrachtet die Korrelation von Symbolen in einem zeitdiskreten Signal und versucht, die Intersymbolredundanz zu verringern

- Lauflängencodierung (RLE): nur effektiv wenn Basis des Zahlensystems klein und Anzahl der Wiederholungen (runs) groß ist

- statische Patternsubstitution: bestimmte Symbolfolgen treten häufig auf und bekommen fixe kurze Codeworte zugewiesen (z.B. "sch" in der deutschen Sprache)

- ein Escape-Zeichen ist nötig

- Lempel-Ziv-Welch (LZW): alle Symbole werden in das Ausgangswörterbuch geschrieben, dann wird dieses dynamisch vercollständigt

- Quellencodierung

- Gruppe der Dekorrelation: Prädiktion und Transformationscodierung

- Prädiktion: basiert auf differentieller Codierung, versucht Aussagen über Signalwerte anhand bereits bekannter Signalwerte zu treffen

- Wert wird einem Prädiktormodul zugeführt, das einen Schätzwert ermittelt, der Unterschied zum tatsächlichen Wert (tatsächlicher Wert - Schätzwert) wird dann übertragen

- Nachteil: Pufferung der bisherigen Werte notwendig

- einfachste Form: Differential Pulse Code Modulation (DPCM) bei Audiosignalen, Schätzwert = vorheriger Wert

- Prädiktion bei Bilddaten: kontextabhängige Prädiktormodi z.B. zum Erkennen einer vertikalen Kante

- Transformationscodierung: Transformierung vom Orts-/Zeitraum in den Frequenzraum (damit kann leichter gearbeitet werden und es bieten sich mehr Möglichkeiten für Kompression)

- Transformation ist nicht verlustbehaftet und reversibel

- wichtige Transformationen: Discrete Fourier Transformation (DFT, bei Audiokompression) und Discrete-Cosinus-Transformation (DCT, bei Bild- und Videokompression)

JPEG

- 1992 von der Joint Photographic Experts Group (Gründung 1985 als Projektgruppe der ITU) spezifiziert, große Verbreitung durch das Internet

- hybrides Kompressionsverfahren, Bildsignal durchläuft verschiedene Codierungsschritte

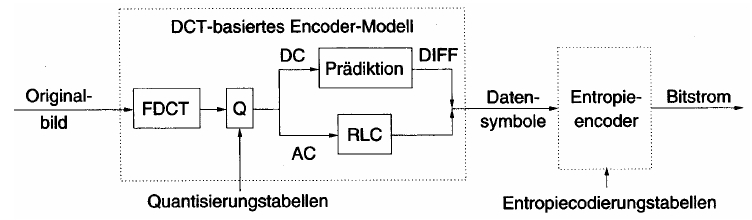

- Vorverarbeitung (Zerlegung in Makroblöcke, Umwandlung in YCrCb) → Transformation (DCT) → Quantisierung (der Koeffizienten) → Entropiecodierung (RLE und Huffman)

- Zerlegung in Farbkomponenten (YCbCr) mit 8bit für jeden Farbwert, Subsampling 4:2:0 → Farbinformationen können vom menschlichen Auge nicht so gut unterschieden werden wie Helligkeitsinformationen

- Transformation jeder Komponente in 8x8-Makroblöcken mittels DCT

- die 64 Bildpunkte werden in 64 Frequenzbereiche umgeformt

- der 0,0-Koeffizient wird DC-Koeffizient genannt und steht für den mittleren Grauwert des Blocks

- die übrigen Koeffizienten heißen AC-Koeffizienten und überlagern die Grundfrequenz des DC-Koeffizienten

- diese Transformation hat noch keinen Informationsverlust zur Folge

- (verlustbehaftete) Quantisierung der (Fließkomma-)Koeffizienten mittels einer Quantisierungsmatrix

- es können unterschiedliche Matrizen für Luminanz und Chrominanz verwendet werden

- der Quantisierungsfaktor bestimmt maßgeblich die Datenmenge und die subjektive Qualitätseinstufung des Bildes

- die DC-Koeffizienten durchlaufen einen Prädiktor und der Schätzfehler wird übertragen

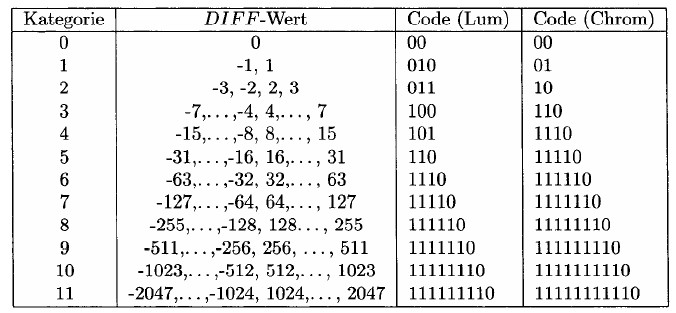

- dieser wird Huffman-codiert mittels einer Tabelle, die den (großen) Wertebereich des DC-Koeffizienten in 12 Kategorien einteilt

- es muss nun ein Symbol für die Kategorie des Schätzfehlers übertragen werden und eines für den konkreten Wert

- die Kategorie legt gleichzeitig die Anzahl der benötigten Bits für den konkreten Wert fest

-

- Beispiel für DC[i] Wert 78 (Luma): Bitstrom 11110|1001110 (Kategorie 7, Wert 78)

- Beispiel für DC[i+1] Wert 66 (Luma), DIFF = 66 - 78 = -12: Bitstrom 101|0011 (Kategorie 4, Wert -12 = -15 + 3)

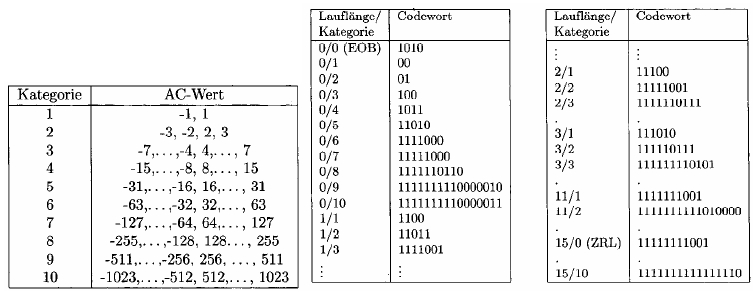

- die AC-Koeffizienten werden Lauflängen-codiert

- sie nehmen üblicherweise kleine Werte an, die sich nur marginal unterscheiden

- sie werden im Zick-Zack-Muster ausgelesen, da sich die höherfrequenten Anteile im oberen linken Bereich des Blocks konzentrieren → höhere Wahrscheinlichkeit für Nullwerte am Ende des Vektors der AC-Werte

- auch die AC-Koeffizienten, die nicht 0 sind, werden mit zwei Symbolen codiert: eine Kategorie und die Anzahl der benachbarten Nullen

- Sonderwerte: 15/0 (ZRL, 16 Nullwerte), 0/0 (EOB)

-

- Beispiel AC 2|0|0|0: Bitstrom 111110111|10 (Kategorie 2, 0-Lauflänge 3 → 3/2, Wert 2)

- Verarbeitungsmethoden

- sequentiell: ein einziger Durchlauf, blockweise von links oben nach rechts unten → jeder Block wird unabhängig verarbeitet, was zu einer großen Speichereffizienz führt

- progressiv: mehrere Durchläufe, erst grob aufgelöst, dann feiner → Overhead, da für jede Progression die Position der Blöcke gespeichert werden muss

- spektrale Selektion: zuerst werden die tieffrequenten Koeffizienten übertragen, dann die hochfrequenten

- schrittweise Approximation: die obersten Bits aller Koeffizienten werden zuerst gesendet

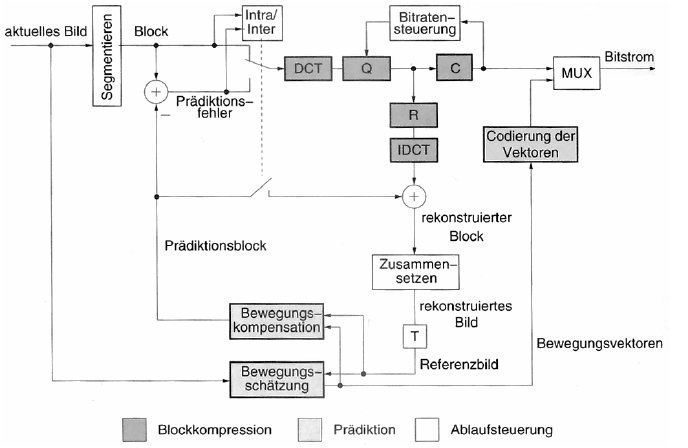

Bewegtbildkompression

- zusätzlich zur Bildkompression die 4. Dimension Zeit

- Framerate: Geschwindigkeit der Bildabfolge in Frames (Einzelbilder) pro Sekunde

- Intraframecodierung: isolierte Komprimierung der Einzelbilder (z.B. Motion-JPEG)

- Ziel eines jeden Video-Codecs muss es sein, eine höhere Kompression als die Intraframecodierung zu erreichen und die Interframeredundanz zu eliminieren

- erster Ansatz: nur Veränderungen zwischen den Frames übertragen (Differenzcodierung)

- besser: Bewegungserkennung und Übertragung der Bewegungsvektoren

- komplexe Bewegungen wie Rotationen, Skalierungen und Verformungen könnten zwar berechnet werden, das ist aber zu aufwändig, sodass meist nur Verschiebungen von Objekten erkannt werden

- schwierige Bildteile werden absolut codiert

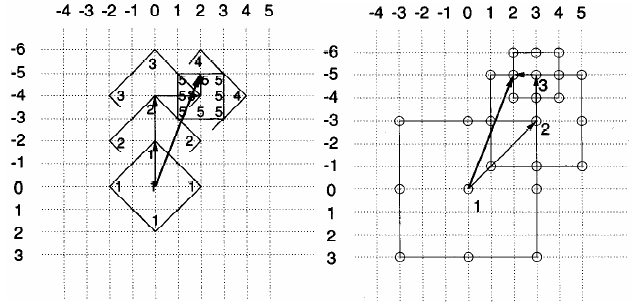

- Blockmatching

- Aufteilung des Bildes in 16x16-Blöcke (Kompromiss aus Genauigkeit und Aufwand)

- Finden einer Verschiebung durch Ermittlung des geringsten mittleren quadratischen Fehlers zwischen Ausgangsblock und neuem Bild

- Festlegen der Schwellenwerte δ und Δ

- MSE < δ: Codierung durch Verschiebungsvektor

- δ < MSE < Δ: Codierung durch Verschiebungsvektor und Prädiktionsfehler → Differenzcodierung

- Δ < MSE: absolute Codierung

- alle möglichen Verschiebungen werden aus Performancegründen nicht betrachtet

- Methoden

- logarithmische Suche (kommt geringfügig schneller zum Ziel)

- 3-Stufen-Suche (fest vorgegebene Anzahl an Schritten)

- neuere Methoden berechnen auch Halb- und/oder Viertelpixel (Interpolation) um eine noch genauere Verschiebung zu ermitteln

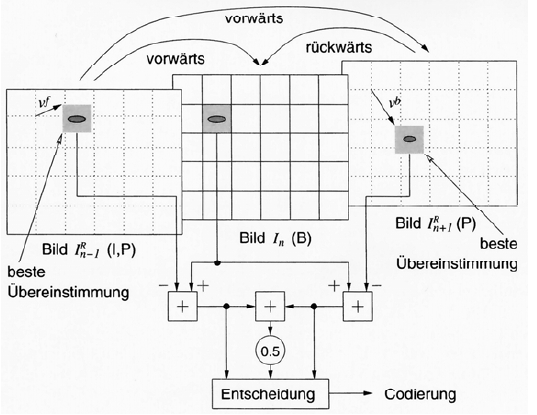

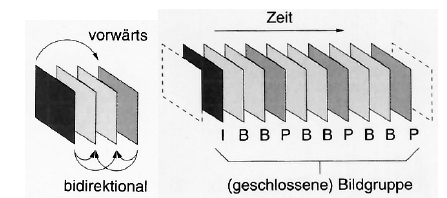

- zukünftige Inhalte lassen sich meist schwer vorhersagen, weshalb es sinnvoll ist, auch spätere Bilder zum Blockmatching zu verwenden (Bidirektionale Prädiktion)

- Arten von Frames: I = intraframecodiert, P = Vorwärtsprädiktion, B = bidirektionale Prädiktion

MPEG

- 1988 enstand die Motion Picture Experts Group mit dem Ziel ein Verfahren für die Video- und Audiokompression zur Verwendung auf CD-ROMs zu standardisieren

- 1993 wurde MPEG1 offiziell freigegeben

- nur der Bitstrom und die Funktionsweise des Decoders wurde spezifiziert, nicht jedoch, wie ein Encoder zum Bitstrom gelangt → Möglichkeiten zur Optimierung durch verschiedene Implementierungen

- die Optimierung durch diese Konkurrenz ist beachtlich: 1995 wurden noch 6MBit/s für einen optisch ansprechenden Bitstrom benötigt, heute nur noch 2MBit/s ohne den Decoder wechseln zu müssen

- MPEG1 sollte Videodaten auf Video-CDs bereitstellen → max. 1,5MBit/s (einfache CD-ROM-Geschwindigkeit) mit VHS-Qualität

- Auflösung ist die Hälfte von PAL: 352x288 oder 352x240 (NTSC)

- jeder Decoder sollte mindestens unterstützen

- Horizontalauflösung ⇐ 768

- Vertikalauflösung ⇐ 576

- Makroblöcke pro Bild ⇐ 396

- Frames pro Sekunde ⇐ 30

- Bitrate ⇐ 1,86MBit/s

- Bild muss für PAL und NTSC skaliert werden

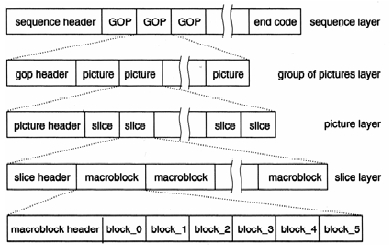

- MPEG1 spezifiziert…

- Systemschicht: Verfahren zum Zusammenfassen der Video- und Audiodaten zu einem gemeinsamen Transportstrom, Organisation in Paketstruktur

- Videokompression

- Sequenzstrom ist aufgeteilt in GOPs, die immer mit einem I-Frame beginnen (Anzahl und Abfolge von B- und P-Frames stehen im GOP-Header und sind nicht durch MPEG spezifiziert)

- Frames sind unterteilt in Slices, die die Makroblöcke des Bildes enthalten

- Makroblöcke bestehen aus 4 8x8-Luminanzblöcken und 2 8x8-Chrominanzblöcken (→ Farbsubsampling 4:2:0)

- Audiokompression

- Layer 1: CD-I, DCC

- Layer 2: DAB (digitales Radio)

- Layer 3: MP3

- Testvorschriften

- Software-Referenzmodell

- 1990 wurde mit der Arbeit an MPEG2 begonnen

- bessere Kompressionsraten bei höherer Bildqualität

- Ziel Anpassbarkeit an unterschiedliche Medien und Übertragungsgeschwindigkeiten

- 1998 verabschiedet

- abwärtskompatibel zu MPEG1

- insg. 10 Parts, zusätzlich zu den 5 von MPEG1

- Steuerung von digitalen Speichermedien (Einsatz im digitalen Fernsehen, Übertragung interaktiver Inhalte)

- nicht abwärtskompatible Audiokompressionsverfahren (Advanced Audio Coding)

- Real Time Interface

- DSM-CC Conformance

- Intellectual Property Management & Protection (IPMP)

- Levels: heben die starre Bildauflösung auf und ermöglichen höhere Auflösungen (bis zu 1920x1152)

- Profiles: kennzeichnen den Aufbau der GOPs und die Skalierbarkeit des Films

- Base Layer hochverfügbar, Enhancement Layer zur optionalen Qualitätssteigerung

- SNR-scaling: unterschiedliche Bildqualität bei gleicher örtlicher Auflösung

- spatial-scaling: unterschiedliche Auflösung, z.B. PAL und HDTV über einen Kanal

- temporal-scaling: Basisstrom enthält weniger Bilder, Zwischenframes werden interpoliert

- hybrid-scaling: Kombination aus obigen

- Farbsubsampling kann variiert werden: 4:2:0, 4:2:2, 4:4:4

- es können auch Halbbilder übertragen werden

- Audio: AAC, 5.1

- Datenströme

- Programmstrom zur Speicherung auf sicheren Medien, lange Datenpakete

- Transportstrom zur Übertragung auf fehleranfälligen Kanälen, kurze Pakete, Fehlerkorrektur und Redundanz

- die Arbeit an MPEG3 wurde eingestellt, da die anvisierten Optimierungen auch mit MPEG2 möglich waren

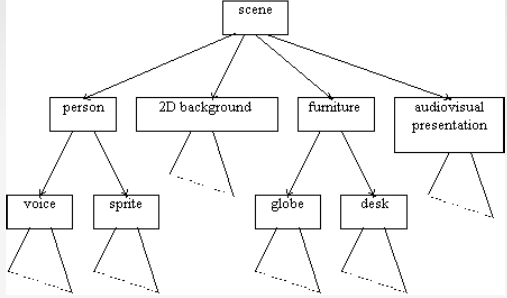

- 2000 wurde mit der Arbeit an MPEG4 begonnen

- Ziel: objektorientiertes Format mit Fokus auf interaktive Inhalte, synthetisch erzeugte Inhalte (Animationen) und Streaming

- universeller Codec für synthetische und natürliche Inhalte und nahezu alle Speicher- und Übertragungskanäle

- unterstützt interaktive, multimediale Computersysteme

- ermöglicht Kombination von synthetischen und natürlichen Szenen

- unterstützt Multiperspektiven

- Objektorientierung: Information wird segmentiert und als Aufbau von Objekten verstanden, z.B. Hintergrund und Vordergrund können unterschieden werden → Compositings, wichtige Bildinhalte werden schwächer komprimiert, Alphamasken grenzen Objekt zu ihrer Umgebung ab

- Videoszenen werden baumförmig segmentiert (Binary Format for Scenes, BIFS)

- Sprache kann durch Sprachsynthese und MIDI-Daten codiert werden

- Optimierung der Videokompression: Bewegungsschätzung im Viertelpixel-Bereich, Block-Matching kann durch globale Bewegungsschätzung ersetzt werden, Luminanz- und Farbcodierung sind mit frei wählbaren Quantisierungstabellen belegbar

- eigener Objekttyp für Hintergründe, der größer sein kann als das sichtbare Bild und verschoben werden kann

- 17 Parts

- Delivery Multimedia Integration Framework (DMIF): Sitzungs- und Streamingprotokoll, übertragen werden Pointer auf die Inhalte anstatt Download

- Umfang ist so groß, dass er kaum umgesetzt werden konnte → Videokomprimierungsanteil wurde 2003 gemeinsam mit der ITU spezifiziert: H.264/AVC

- Gemeinsamkeiten mit früheren Standards

- Luma-Chroma-Subsampling 4:2:0

- Makroblöcke

- Slices als Sequenz von Makroblöcken

- I-, B-, P-Frames

- Voll- und Halbbildmodus

- Verbesserungen

- Makroblöcke können bis auf 4x4 unterteilt werden

- Bewegungsvektoren mit Viertelpixel-Genauigkeit

- Bewegungsvektoren dürfen über die Bildgrenzen hinausragen

- multiple Referenzbilder für Bewegungsschätzung sind möglich

- Prädiktion in 9 verschiedenen Modi (horizontal, vertikal, diagonal in mehreren Abstufungen)

- Deblocking-Filter reduziert Blockartefakte

- Referenzierung wird von der Reihenfolge der Bilder losgelöst

- gewichtete Mittelung von Referenzblöcken bei bidirektionaler Prädiktion

- Umschalten von Vollbild- und Halbbild-Modus auf Makroblock-Ebene

- örtliche Prädiktion von Blöcken

-

- MPEG1: Video auf CD-ROM, VHS-Qualität, 1,5MBit/s

- MPEG2: TV/HDTV/DVD, Qualitätsprofile, 4-8MBit/s

- MPEG4: universelle Anwendung, objektbasiert, 5kBit/s-4MBit/s

Audiokompression

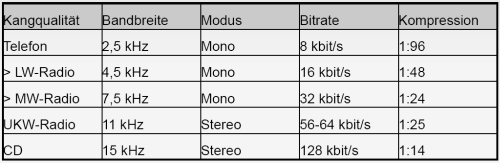

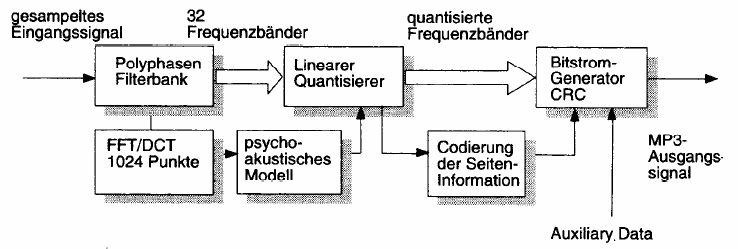

- Audiodaten liegen als zeitdiskreter Bitstrom von Samplingwerten vor → Transformation mittels FFT in den Frequenzraum

- mehrere Samples werden blockweise (Frames) transformiert (bei MP3 Fensterbreite 1152 Samples)

- Filterband teilt das Signal in schmalbandige Frequenzbänder auf

- Maskierungen und die Tatsache, dass Menschen komplexe Schallsignale in Gruppen wahrnehmen, führen zu 24 kritischen Frequenzbändern im Bereich zwischen 16Hz und 16kHz mit ungleicher Breite (ansteigend mit Frequenz)

- MP3 verwendet 32 gleichmäßige Frequenzbänder mit 6 oder 18 möglichen Subbändern (je nach Filterbank)

- die Komprimierung des Signals findet statt, indem die Frequenzbänder durch ein psychoakustisches Modul geschleust werden

- Ermittlung des Leistungsdichtespektrums und der Frequenz des Spitzenpegels im Band → Maskierungsschwelle

- die Maskierungsschwelle wird mit der Ruhehörschwelle verrechnet und heraus kommt die minimale Bitanzahl pro Band, die das Signal (ohne Rauschen über der Hörschwelle) quantisiert

- optimales Subsampling, das das menschliche Ohr nicht wahrnehmen kann

- das Ergebnis geht in die Quantisierung und Codierung der Teilfrequenzbänder ein (Mono und Stereo bis zu 224kbit/s)

- das Verfahren ist stark asymmetrisch (Decodierung ist weniger aufwändig als Codierung)

- Metainformationen: CRC-Checksummen, ID3-Tags

- Stereo-Signale

- Joint Stereo: Mono-Summensignal und Differenzsignale mit Panoramaschwankungen

- Intensity Stereo: verlustbehaftet, untere Frequenzbereiche (Bässe) werden mono-codiert da die Ortung durch das menschliche Ohr schlecht ist

- Dateiaufbau: jeder Frame hat eigenen Header und Prüfsummen → Streaming möglich

- MP3: MPEG1 Layer 3

- 33, 44.1, 48kHz

- 32-224kbit/s

- AAC: bessere Komprimierung und Multikanalunterstützung

- MPEG2 und 4

- 5.1-Kanäle

- geringere Bandbreiten (8kbit/s) und Abtastraten (16kHz) möglich

- vergleichbare Qualität zu MP3 mit 70% der Bitrate

- nicht abwärtskompatibel zu MP3

- Aufteilung des Signals in 1024 Teilbänder und Transformation mittels DCT

- Temporal Noise Shaping (TNS)

- Kompensierung von Quantisierungsfehlern (Rauschen) im Zeitbereich durch Prädiktion insb. bei Sprache

- Verrechnung der Überlappung an den Grenzen der Frequenzbänder

- Rückwärtsprädiktion verringert die Codewortlängen

- Mehrkanalcodierung (M/S): Monosignal und Differenz der Stereomitte in weiteren Kanälen

- Quantisierung durch Gleitkomma-Quantisierung führt zu konstanterem SNR

Links

ToDo

- Unterscheidung BAS / FBAS

- LZW und Huffman im Baum durchspielen

- logarithmische und 3-Step-Suche am Beispiel durchführen

Klausur

- Gegenüberstellungen

- Zusammenhänge

- Detailfragen

- Flash-Codeausschnitte kommentieren

- Hilfsmittel: Taschenrechner

- Skype: maddias.r

Begriffe

-

- Ein Algorithmus ist eine eindeutige Abbildung.

-

- Zu jedem Zeitpunkt ist der nachfolgende Abarbeitungsschritt eines Algorithmus eindeutig festgelegt.

- Kontinuität (analoge Signale)

- lückenloser Zusammenhang, Stetigkeit, stetige Werte

-

- räumliche oder zeitliche Trennung von Objekten oder Ereignissen

- Periode = Schwingungsdauer T

- Eine Periode ist die kleinste Zeitdauer einer sich wiederholenden physikalischen Erscheinung.

- Frequenz f

- Kehrwert der Periode

-

- Zeitabhängigkeit der veränderlichen Zustandsgrößen ist sinusförmig.

- t und F sind unabhängig von Amplitude.

- Konvergenz <> Divergenz

- Existenz eines Grenzwertes bei einer Folge

-

- Gebilde mit hoher Selbstähnlichkeit (Beispiel: Mandelbrot-Menge)

-

- Beziehung zwischen zwei oder mehr statistischen Variablen (nicht zwingend kausal).

ToRead

- DIN 33401

se/multimedia.1237746952.txt.gz · Zuletzt geändert: 2014-04-05 11:42 (Externe Bearbeitung)