Benutzer-Werkzeuge

se:multimedia

Inhaltsverzeichnis

Multimedia

Lernziele

- die physiognomischen Eigenheiten von Hören und Sehen kennen

- den Aufbau analoger Fernsehübertragungstechnik kennen

- das analoge Fernsehsignal in seinen Grundzügen nachvollziehen

- die Motivation der digitalen Signalverarbeitung nachvollziehen

- Methoden und Begriffe der Digitalisierung analoger Signale kennen

- wichtige Begriffe der Datenkompression und Datencodierung kennen

- verlustfreie und verlustbehaftete Kompressionsmethoden kennen

- die Verarbeitungsschritte des JPEG-Encoders kennen

- Verfahren der Interframe- und Intraframecodierung kennen

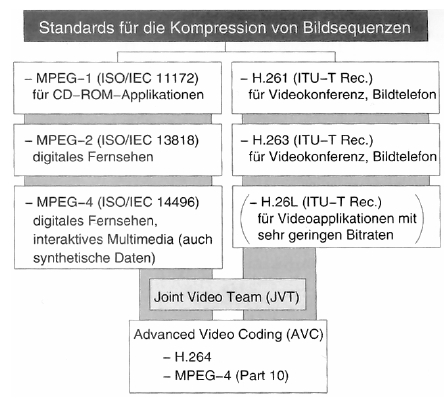

- die Evolutionsstufen der MPEG-Familie kennen

- die in MPEG verwendeten Kompressionsalgorithmen kennen

- den Aufbau des MPEG-Bilddatenstroms sowie Level und Profile kennen

- die Audiokompressionsverfahren der MPEG-Familie kennen

- die Anwendung psychoakustischer Erkenntnisse bei MPEG nachvollziehen

- die wichtigsten Dateiformate für Multimedia-Inhalte kennen

- wissen, welche Formate für welchen Zweck adäquat sind

- wichtige Werkzeuge und Geräte in der Medienproduktion kennen

- Grundlagen der elektronischen Klangerzeugung und Musikproduktion kennen

- verschiedene Alternativen bei der Medienproduktion identifizieren

- wichtige Netzwerkprotokolle und -dienste kennen und ihre Anwendungsgebiete benennen können

- Client- und Server-seitige Techniken kennen und identifizieren können, für welchen Zweck welche Technik adäquat ist

- wichtige Trends des WWW kennen und evaluieren können

- ermutigt sein, selbst neue Trends im WWW zu entdecken

Einleitung

- Kommunikation ist die zielgerichtete, kanalgebundene Übertragung von Informationen von einem Sender zu einem oder mehreren Empfängern.

- Kommunikationskanäle zwischen Menschen

- textuell (Wort und Schrift)

- visuell (Licht und Farbe)

- auditiv (Ton, Klang, Sprache)

- taktil (Fühlen von Kräften, Texturen, Temperaturen)

- olfaktorisch (Riechen und Schmecken)

- Wahrnehmung von Bewegung und Beschleunigung

- im Zentrum von Multimedia stehen Menschen und ihre Wege, mit anderen Menschen und ihrer Umwelt zu kommunizieren

- Multimedia ist der Trend, die Kanäle, über die Menschen mit ihrer Umwelt kommunizieren, mit Mitteln der Informationswissenschaft über alle Quellen zu integrieren und als Gesamtheit für die Kommunikation zu nutzen.

- Multimedia-Kanäle: Text, Bild, Film/Video, Internet, Virtual Reality, Audio

Wahrnehmung

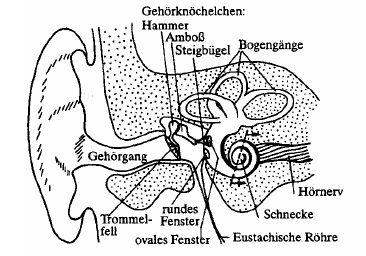

Hören

- akustische Phänomene, die das Gehör wahrnimmt, sind Kompressionen und Verdünnungen der Luftmoleküle

- die Druckwellen treffen auf das Trommelfell und werden über die Ohrknöchelchen an die Cochlea übermittelt

- feine Flimmerhärchen in der mit Lymphflüssigkeit gefüllten Cochlea schwingen und geben elektrische Impulse ans Gehirn weiter

- das menschliche Gehör kann Schallereignisse im Bereich von 18 Hz bis 20.000 Hz wahrnehmen

- Töne tiefer Frequenz benötigen einen höheren Schalldruck, um wahrgenommen zu werden → Hörschwelle

- Schmerzschwelle: Schalldruck, ab dem die Rezeption zu Schmerzempfinden führt

- Hörfeld: Bereich zwischen Hörschwelle und Schmerzschwelle

- Einheiten

- physikalisch: Dezibel als (logarithmische) Einheit für den Schalldruck → menschliche Wahrnehmung ist nicht linear zur Frequenz

- phsychoakustisch: Phon als Einheit für die Lautstärke (Lautstärkeempfinden von Frequenzen im Bezug auf den 1kHz-Sinuston) → kein quantitativer Vergleich von Lautstärken möglich, da Lautstärkeempfinden nicht proportional zu den Phon-Werten ist

- Sone (N) als Einheit für die (subjektive!) Lautheit (qualitativer Vergleich von Klangereignissen), 1 sone = 40 Phon

- Umrechnung: N = 2(LN - 40) / 10

- Psychoakustik: Teilgebiet der Psychophysik, das versucht, die Zusammenhänge zwischen physikalischen Eigenschaften von Schallsignalen und dem menschlichen Hörempfinden zu beschreiben

- psychoakustische Phänomene

- tonale Maskierung: schmalbandiger Schall einer bestimmten Intensität löscht Frequenzen geringerer Lautstärke in seinem Frequenzumfeld aus (Mithörschwelle: Grenze, ab der der Ton wahrgenommen wird), Effekt ist abhängig von Frequenz und Schallpegel des Maskierers

- temporale Maskierung (Vor- und Nachverdeckung): Maskierung vor (20ms) und nach (200ms) Auftreten des Maskierers

- Schwebung und Rauhigkeit: zwei Töne ähnlicher Frequenz werden als ein Ton bestimmter Tonhöhe wahrgenommen, wobei der Schall durch die Phasenverschiebung eine Schwebung erfährt

- je größer die Frequenzdifferenz, umso rauher klingt der Ton, bishin zur Wahrnehmung zweier unterschiedlicher Töne

- Residuum: Töne von Instrumenten setzen sich aus Grundton und Obertönen (Harmonische, Frequenzen sind ganzzahlige Vielfache des Grundtons) zusammen, filtert man den Grundton heraus, vervollständigt das menschliche Gehör die fehlende(n) Grundschwingung(en) zum ursprünglichen Klangbild

- kritische Bänder: Schallereignisse werden in Frequenzgruppen wahrgenommen, deren Gruppenbreite mit steigender Frequenz zunimmt

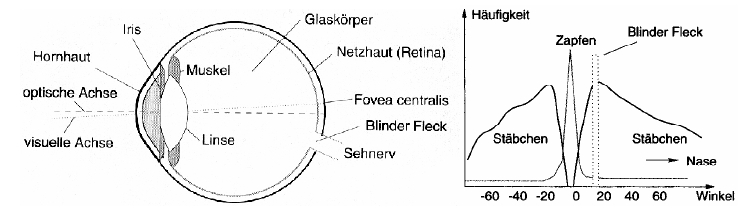

Sehen

- Licht fällt durch die Hornhaus, Iris und Linse auf die Netzhaut (Retina)

- Rezeptoren auf der Retina wandeln die Lichtinformationen in elektrische Impulse

- Zapfen: farb-/helligkeitsempfindlich, 3 Typen: A grün, B gelb-rot, C violett, arbeiten bei Tageslicht optimal, Anzahl 6 Millionen

- Stäbchen: nur helligkeitsempfindlich, empfindlicher als Zapfen, Anzahl 120 Millionen

- fovea centralis: Punkt größter Sehschärfe, hier sind nur Zapfen vorhanden

- wahrnehmbares Licht: 780nm (rot) - 390nm (violett)

- blinder Fleck: hier bündeln sich die Nervenbahnen des Auges zum Sehnerv

- Gehirn verarbeitet Informationen und erzeugt ein Bild, blinder Fleck wird interpoliert, Farbinformationen werden gemischt, unterschiedliche Bilder der zwei Augen ermöglichen räumliches Sehen

- das Auflösungsvermögen des Auges ist biologisch begrenzt

- bestimmte Detailtiefe wird nicht mehr wahrgenommen

- ruhende Objekte werden besser erfasst als sich bewegende

- Helligkeitsunterschiede werden besser erfasst als Farbunterschiede

- maximale Farbempfindlichkeit bei gelb-grün

- 20 Bilder pro Sekunde werden bereits als kontinuierliche Bildfolge wahrgenommen

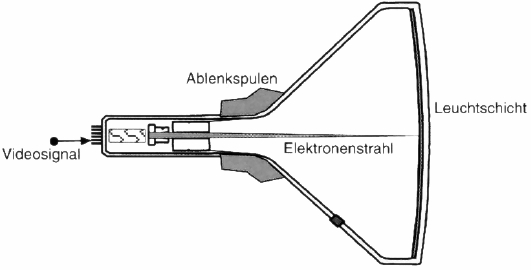

Analoge Fernsehtechnik

- Elektronen werden durch Magnetspulen abgelenkt und bringen auf einer Mattscheibe ein fluoreszierendes Material zum Leuchten

- Elektronenstrahl läuft zeilenweise über das Bild, Nachleuchten der Fluoreszenzschicht vermittelt Eindruck eines Bildes

- inverse Funktionsweise kann für Kameras verwendet werden

- Erkenntnisse über das Auflösungsvermögen des Auges führten zu einer Zahl von mindestens 600 Zeilen pro Bild

- alle Zeilen nacheinander abzuarbeiten (progressive, 25 Vollbilder) führt zu Flimmern → interlaced mode (50 Halbbilder)

- Parameter von PAL

- 625 Zeilen, 576 sichtbar

- Vertikalfrequenz: 50Hz, Bilddauer 20ms

- Horizontalfrequenz: 50 * 312,5 = 15625Hz, Zeilendauer 64 Mikrosekunden

- YUV Farbmodell

- Signalübertragung

- Bild-Austastung-Synchronisation (BAS)

- Bildsignal: analoge Grauwertübertragung einer Bildzeile, Signalbereich 0,7 Volt

- Austastungssignal: Signal beim Strahlenrücklauf (horizontal vs. vertikal), Pegel unter Schwarzbereich, in Austastlücke werden Metainformationen übertragen (VPS, Videotext, Prüfsignale)

- Synchronisationssignal: dient der Synchronisation jeder Bildzeile/Halbbild, Übertragung in der Austastlücke

- Farbsysteme

- additiv: selbstleuchtende Farben (z.B. Fernseh-/Computerbildschirme), RGB, alle Farben zusammen ergeben weiß

- subtraktiv: beleuchtete Träger (z.B. Offsetdruck), CMYK, alle Farben zusammen ergeben schwarz

- Farbfernsehen: PAL → YUV-Modell (Y = Helligkeit/Luminanz, UV = Farbdifferenz/Chrominanz)

- Y = 0,299R + 0,587G + 0,114B

- U = (B - Y) * 0,493

- V = (R - Y) * 0,877

- gelb-grün-Anteil trägt wesentlich zum Helligkeitsempfinden bei

- Kameras enthalten Rot-, Grün- und Blaufilter

- Farbmonitore enthalten drei Elektronenquellen

- BAS → FBAS (F = Farbe): Übertragung der Fardifferenzen in der Austastlücke

- Fernsehstandards

- NTSC (National Television Systems Committee): 720x485x30, YiQ Farbmodell

- PAL (Phase Alternating Line): 720x576x25, YUV Farbmodell

- SECAM (sequentiel couleur a memoire): Abwandlung von PAL, YiQ Farbmodell

Digitalisierung

- bis in die 90er Jahre wurden mediale Inhalte hautpsächlich analog produziert und rezipiert (Schallplatten, Musikkassette, VHS)

- Unterschiede analog/digital

- kontinuierliche, analoge Signale <> diskontinuierliche, diskrete Signale

- Generationsverlust <> kein Generationsverlust

- Störanfälligkeit im Übertragungskanal <> binäre Übertragung

- Vorteile der Digitalisierung

- Computer arbeiten digital

- die Bearbeitung und Verarbeitung von Medien in digitaler Form ist einfacher

- Datenkompression ist in digitalen Formaten einfacher zu realisieren

- Fehlerschutz- und -korrekturmechanismen sind möglich

- Kopien sind ohne Generationsverlust durchführbar (entscheidender Punkt!)

- Digitalisierung von Audioinhalten

- liegen als kontinuierliche, analoge, elektrische Signale vor → unendlich viele Werte beliebiger genauer Auflösung

- Abtastung zu bestimmten Zeitpunkten und Überführung in diskreten Wertebereich → Digitalisierung

- Abtast-/Samplingrate: Frequenz, mit der Werte im Signal abgetastet werden

- Shannon-Nyquist-Theorem: fa > 2 * fmaxHz

- wird das SNT missachtet kann das Ausgangssignal nach der Digitalisierung nicht mehr eindeutig rekonstruiert werden

- menschliches Gehör kann bis zu 20kHz wahrnehmen → Abtastrate > 40kHz

- Quantisierung: Überführung der kontinuierlichen Amplitudenwerte eines Signals in diskrete Werte

- Auflösung in bit legt die Anzahl der zulässigen Werte fest

- Quantisierungsfehler wird umso größer, je geringer die Auflösung ist → bei Audio als Rauschen hörbar

- Signal to Noise Ratio (SNR): SNR = 20 * log (ASignal / ARauschen) dB

- jedes zusätzliche Bit in der Quantisierungsauflösung resultiert in einer Erhöhung der Klangdynamik um 6dB bei gleichzeitiger Reduzierung des Rauschens um 6dB

- Pulse Code Modulation (PCM): linear = gleichmäßige Quantisierungsstufen, nicht-linear = logarithmische Quantisierungsstufen → geringere Auflösung im unteren Wertebereich

- CD-Audio: Abtastrate 44kHz, Auflösung 16bit

- Digitalisierung von Bildinhalten

- Zerlegung des Bildes in Raster bestimmter Auflösung, zeilenweise Abtastung

- Auflösung: Anzahl Zeilen und Bildpunkte pro Zeile

- Quantisierung: Anzahl der Graustufen pro Pixel

Datenkompression

- Ablauf

- ein Signal x wird durch einen Encoder in ein komprimiertes Signal y gewandelt und durch den Übertragungskanal geschickt

- der Empfänger ermittelt mit Hilfe eines Decoders das Ausgangssignal x'

- bei verlustloser Kompression werden redundante Informationen gelöscht (Entropiekodierung) und x' entspricht genau x

- bei verlustbehafteter Kompression werden irrelevante Informationen gelöscht und x' ist nicht gleich x

- Anforderungen an Kompressionsverfahren

- minimale Anzahl an bits

- Eindeutigkeit / Rekonstruierbarkeit

- kleinstmöglicher Unterschied zwischen Eingangs- und Ausgangssignal

- Kategorien: Entropiecodierung / Quellencodierung

- Reduktion redundanter Daten <> Reduktion irrelevanter Daten

- universell <> an zu komprimierenden Datenstrom angepasst

- verlustfrei <> verlustbehaftet

- Entropiecodierung: Verfahren, bei denen Auftrittswahrscheinlichkeiten zwischen verschiedenen unabhängigen Symbolen eines Alphabets zur Reduktion der Datenmenge ausgenutzt werden

- Informationsgehalt eines Zeichens: Ii = log (1 / pi) bit

- Entropie: mittlerer Informationsgehalt, Summe der Produkte aus Wahrscheinlichkeiten und Informationsgehalten aller Symbole

- statistische Codierungsverfahren versuchen, dem Wert H für die Entropie möglichst nahe zu kommen, Symbole mit hoher Wahrscheinlichkeit bekommen kürzere Codewörter zugewiesen

- Problem bei Codewörtern ungleicher Länge: Trennzeichen sind nötig oder Verwendung von Prefix-Codes

- Huffman-Code als Beispiel für Prefix-Codes

- Präcodierung: betrachtet die Korrelation von Symbolen in einem zeitdiskreten Signal und versucht, die Intersymbolredundanz zu verringern

- Lauflängencodierung (RLE): nur effektiv wenn Basis des Zahlensystems klein und Anzahl der Wiederholungen (runs) groß ist

- statische Patternsubstitution: bestimmte Symbolfolgen treten häufig auf und bekommen fixe kurze Codeworte zugewiesen (z.B. "sch" in der deutschen Sprache)

- ein Escape-Zeichen ist nötig

- Lempel-Ziv-Welch (LZW): alle Symbole werden in das Ausgangswörterbuch geschrieben, dann wird dieses dynamisch vercollständigt

- Quellencodierung

- Gruppe der Dekorrelation: Prädiktion und Transformationscodierung

- Prädiktion: basiert auf differentieller Codierung, versucht Aussagen über Signalwerte anhand bereits bekannter Signalwerte zu treffen

- Wert wird einem Prädiktormodul zugeführt, das einen Schätzwert ermittelt, der Unterschied zum tatsächlichen Wert (tatsächlicher Wert - Schätzwert) wird dann übertragen

- Nachteil: Pufferung der bisherigen Werte notwendig

- einfachste Form: Differential Pulse Code Modulation (DPCM) bei Audiosignalen, Schätzwert = vorheriger Wert

- Prädiktion bei Bilddaten: kontextabhängige Prädiktormodi z.B. zum Erkennen einer vertikalen Kante

- Transformationscodierung: Transformierung vom Orts-/Zeitraum in den Frequenzraum (damit kann leichter gearbeitet werden und es bieten sich mehr Möglichkeiten für Kompression)

- Transformation ist nicht verlustbehaftet und reversibel

- wichtige Transformationen: Discrete Fourier Transformation (DFT, bei Audiokompression) und Discrete-Cosinus-Transformation (DCT, bei Bild- und Videokompression)

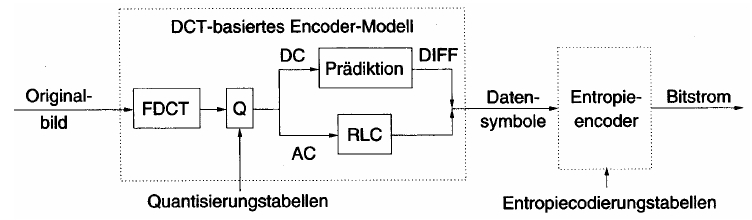

JPEG

- 1992 von der Joint Photographic Experts Group (Gründung 1985 als Projektgruppe der ITU) spezifiziert, große Verbreitung durch das Internet

- hybrides Kompressionsverfahren, Bildsignal durchläuft verschiedene Codierungsschritte

- Vorverarbeitung (Zerlegung in Makroblöcke, Umwandlung in YCrCb) → Transformation (DCT) → Quantisierung (der Koeffizienten) → Entropiecodierung (RLE und Huffman)

- Zerlegung in Farbkomponenten (YCbCr) mit 8bit für jeden Farbwert, Subsampling 4:2:0 → Farbinformationen können vom menschlichen Auge nicht so gut unterschieden werden wie Helligkeitsinformationen

- Transformation jeder Komponente in 8x8-Makroblöcken mittels DCT

- die 64 Bildpunkte werden in 64 Frequenzbereiche umgeformt

- der 0,0-Koeffizient wird DC-Koeffizient genannt und steht für den mittleren Grauwert des Blocks

- die übrigen Koeffizienten heißen AC-Koeffizienten und überlagern die Grundfrequenz des DC-Koeffizienten

- diese Transformation hat noch keinen Informationsverlust zur Folge

- (verlustbehaftete) Quantisierung der (Fließkomma-)Koeffizienten mittels einer Quantisierungsmatrix

- es können unterschiedliche Matrizen für Luminanz und Chrominanz verwendet werden

- der Quantisierungsfaktor bestimmt maßgeblich die Datenmenge und die subjektive Qualitätseinstufung des Bildes

- die DC-Koeffizienten durchlaufen einen Prädiktor und der Schätzfehler wird übertragen

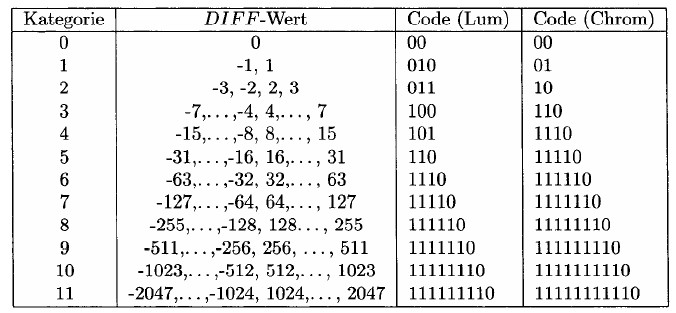

- dieser wird Huffman-codiert mittels einer Tabelle, die den (großen) Wertebereich des DC-Koeffizienten in 12 Kategorien einteilt

- es muss nun ein Symbol für die Kategorie des Schätzfehlers übertragen werden und eines für den konkreten Wert

- die Kategorie legt gleichzeitig die Anzahl der benötigten Bits für den konkreten Wert fest

-

- Beispiel für DC[i] Wert 78 (Luma): Bitstrom 11110|1001110 (Kategorie 7, Wert 78)

- Beispiel für DC[i+1] Wert 66 (Luma), DIFF = 66 - 78 = -12: Bitstrom 101|0011 (Kategorie 4, Wert -12 = -15 + 3)

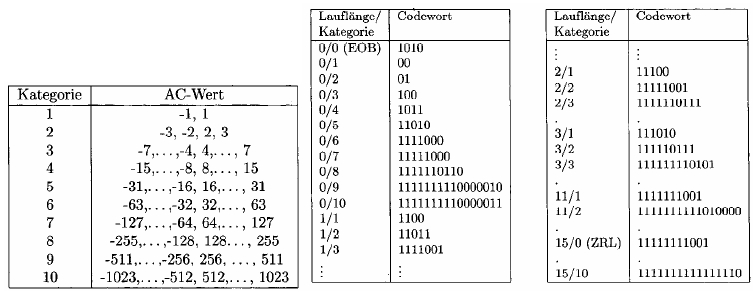

- die AC-Koeffizienten werden Lauflängen-codiert

- sie nehmen üblicherweise kleine Werte an, die sich nur marginal unterscheiden

- sie werden im Zick-Zack-Muster ausgelesen, da sich die höherfrequenten Anteile im oberen linken Bereich des Blocks konzentrieren → höhere Wahrscheinlichkeit für Nullwerte am Ende des Vektors der AC-Werte

- auch die AC-Koeffizienten, die nicht 0 sind, werden mit zwei Symbolen codiert: eine Kategorie und die Anzahl der benachbarten Nullen

- Sonderwerte: 15/0 (ZRL, 16 Nullwerte), 0/0 (EOB)

-

- Beispiel AC 2|0|0|0: Bitstrom 111110111|10 (Kategorie 2, 0-Lauflänge 3 → 3/2, Wert 2)

- Verarbeitungsmethoden

- sequentiell: ein einziger Durchlauf, blockweise von links oben nach rechts unten → jeder Block wird unabhängig verarbeitet, was zu einer großen Speichereffizienz führt

- progressiv: mehrere Durchläufe, erst grob aufgelöst, dann feiner → Overhead, da für jede Progression die Position der Blöcke gespeichert werden muss

- spektrale Selektion: zuerst werden die tieffrequenten Koeffizienten übertragen, dann die hochfrequenten

- schrittweise Approximation: die obersten Bits aller Koeffizienten werden zuerst gesendet

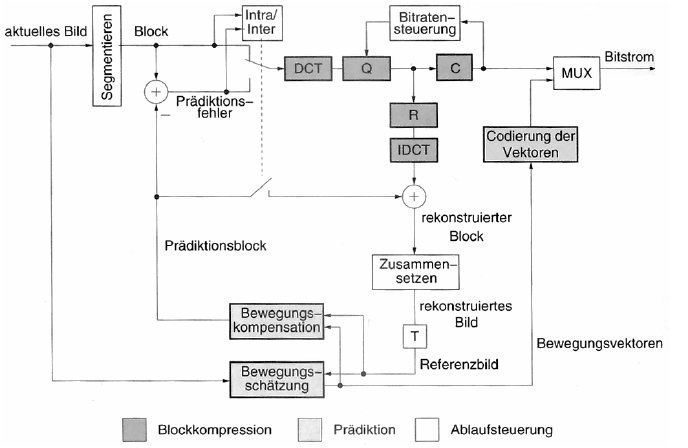

Bewegtbildkompression

- zusätzlich zur Bildkompression die 4. Dimension Zeit

- Framerate: Geschwindigkeit der Bildabfolge in Frames (Einzelbilder) pro Sekunde

- Intraframecodierung: isolierte Komprimierung der Einzelbilder (z.B. Motion-JPEG)

- Ziel eines jeden Video-Codecs muss es sein, eine höhere Kompression als die Intraframecodierung zu erreichen und die Interframeredundanz zu eliminieren

- erster Ansatz: nur Veränderungen zwischen den Frames übertragen (Differenzcodierung)

- besser: Bewegungserkennung und Übertragung der Bewegungsvektoren

- komplexe Bewegungen wie Rotationen, Skalierungen und Verformungen könnten zwar berechnet werden, das ist aber zu aufwändig, sodass meist nur Verschiebungen von Objekten erkannt werden

- schwierige Bildteile werden absolut codiert

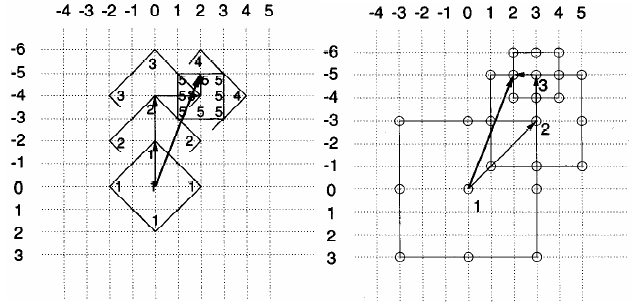

- Blockmatching

- Aufteilung des Bildes in 16x16-Blöcke (Kompromiss aus Genauigkeit und Aufwand)

- Finden einer Verschiebung durch Ermittlung des geringsten mittleren quadratischen Fehlers zwischen Ausgangsblock und neuem Bild

- Festlegen der Schwellenwerte δ und Δ

- MSE < δ: Codierung durch Verschiebungsvektor

- δ < MSE < Δ: Codierung durch Verschiebungsvektor und Prädiktionsfehler → Differenzcodierung

- Δ < MSE: absolute Codierung

- alle möglichen Verschiebungen werden aus Performancegründen nicht betrachtet

- Methoden

- logarithmische Suche (kommt geringfügig schneller zum Ziel)

- 3-Stufen-Suche (fest vorgegebene Anzahl an Schritten)

- neuere Methoden berechnen auch Halb- und/oder Viertelpixel (Interpolation) um eine noch genauere Verschiebung zu ermitteln

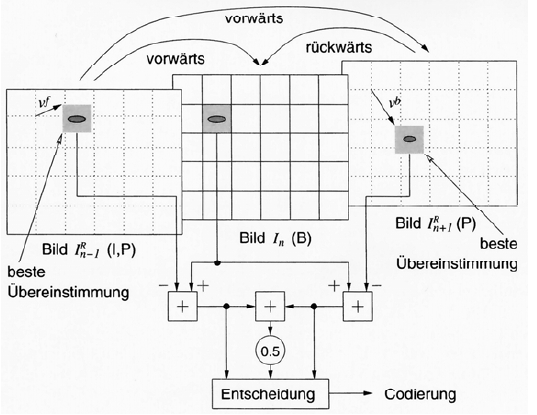

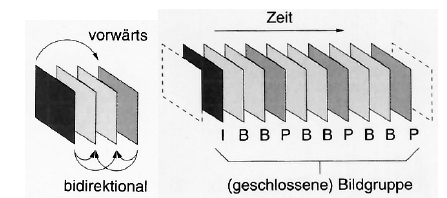

- zukünftige Inhalte lassen sich meist schwer vorhersagen, weshalb es sinnvoll ist, auch spätere Bilder zum Blockmatching zu verwenden (Bidirektionale Prädiktion)

- Arten von Frames: I = intraframecodiert, P = Vorwärtsprädiktion, B = bidirektionale Prädiktion

MPEG

- 1988 enstand die Motion Picture Experts Group mit dem Ziel ein Verfahren für die Video- und Audiokompression zur Verwendung auf CD-ROMs zu standardisieren

- 1993 wurde MPEG1 offiziell freigegeben

- nur der Bitstrom und die Funktionsweise des Decoders wurde spezifiziert, nicht jedoch, wie ein Encoder zum Bitstrom gelangt → Möglichkeiten zur Optimierung durch verschiedene Implementierungen

- die Optimierung durch diese Konkurrenz ist beachtlich: 1995 wurden noch 6MBit/s für einen optisch ansprechenden Bitstrom benötigt, heute nur noch 2MBit/s ohne den Decoder wechseln zu müssen

- MPEG1 sollte Videodaten auf Video-CDs bereitstellen → max. 1,5MBit/s (einfache CD-ROM-Geschwindigkeit) mit VHS-Qualität

- Auflösung ist die Hälfte von PAL: 352x288 oder 352x240 (NTSC)

- jeder Decoder sollte mindestens unterstützen

- Horizontalauflösung ⇐ 768

- Vertikalauflösung ⇐ 576

- Makroblöcke pro Bild ⇐ 396

- Frames pro Sekunde ⇐ 30

- Bitrate ⇐ 1,86MBit/s

- Bild muss für PAL und NTSC skaliert werden

- MPEG1 spezifiziert…

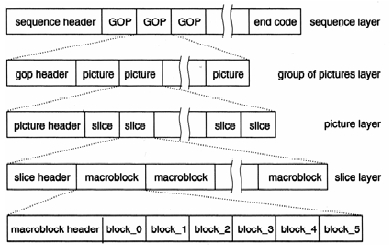

- Systemschicht: Verfahren zum Zusammenfassen der Video- und Audiodaten zu einem gemeinsamen Transportstrom, Organisation in Paketstruktur

- Videokompression

- Sequenzstrom ist aufgeteilt in GOPs, die immer mit einem I-Frame beginnen (Anzahl und Abfolge von B- und P-Frames stehen im GOP-Header und sind nicht durch MPEG spezifiziert)

- Frames sind unterteilt in Slices, die die Makroblöcke des Bildes enthalten

- Makroblöcke bestehen aus 4 8x8-Luminanzblöcken und 2 8x8-Chrominanzblöcken (→ Farbsubsampling 4:2:0)

- Audiokompression

- Layer 1: CD-I, DCC

- Layer 2: DAB (digitales Radio)

- Layer 3: MP3

- Testvorschriften

- Software-Referenzmodell

- 1990 wurde mit der Arbeit an MPEG2 begonnen

- bessere Kompressionsraten bei höherer Bildqualität

- Ziel Anpassbarkeit an unterschiedliche Medien und Übertragungsgeschwindigkeiten

- 1998 verabschiedet

- abwärtskompatibel zu MPEG1

- insg. 10 Parts, zusätzlich zu den 5 von MPEG1

- Steuerung von digitalen Speichermedien (Einsatz im digitalen Fernsehen, Übertragung interaktiver Inhalte)

- nicht abwärtskompatible Audiokompressionsverfahren (Advanced Audio Coding)

- Real Time Interface

- DSM-CC Conformance

- Intellectual Property Management & Protection (IPMP)

- Levels: heben die starre Bildauflösung auf und ermöglichen höhere Auflösungen (bis zu 1920x1152)

- Profiles: kennzeichnen den Aufbau der GOPs und die Skalierbarkeit des Films

- Base Layer hochverfügbar, Enhancement Layer zur optionalen Qualitätssteigerung

- SNR-scaling: unterschiedliche Bildqualität bei gleicher örtlicher Auflösung

- spatial-scaling: unterschiedliche Auflösung, z.B. PAL und HDTV über einen Kanal

- temporal-scaling: Basisstrom enthält weniger Bilder, Zwischenframes werden interpoliert

- hybrid-scaling: Kombination aus obigen

- Farbsubsampling kann variiert werden: 4:2:0, 4:2:2, 4:4:4

- es können auch Halbbilder übertragen werden

- Audio: AAC, 5.1

- Datenströme

- Programmstrom zur Speicherung auf sicheren Medien, lange Datenpakete

- Transportstrom zur Übertragung auf fehleranfälligen Kanälen, kurze Pakete, Fehlerkorrektur und Redundanz

- die Arbeit an MPEG3 wurde eingestellt, da die anvisierten Optimierungen auch mit MPEG2 möglich waren

- 2000 wurde mit der Arbeit an MPEG4 begonnen

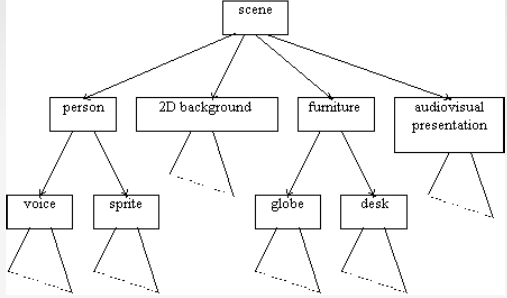

- Ziel: objektorientiertes Format mit Fokus auf interaktive Inhalte, synthetisch erzeugte Inhalte (Animationen) und Streaming

- universeller Codec für synthetische und natürliche Inhalte und nahezu alle Speicher- und Übertragungskanäle

- unterstützt interaktive, multimediale Computersysteme

- ermöglicht Kombination von synthetischen und natürlichen Szenen

- unterstützt Multiperspektiven

- Objektorientierung: Information wird segmentiert und als Aufbau von Objekten verstanden, z.B. Hintergrund und Vordergrund können unterschieden werden → Compositings, wichtige Bildinhalte werden schwächer komprimiert, Alphamasken grenzen Objekt zu ihrer Umgebung ab

- Videoszenen werden baumförmig segmentiert (Binary Format for Scenes, BIFS)

- Sprache kann durch Sprachsynthese und MIDI-Daten codiert werden

- Optimierung der Videokompression: Bewegungsschätzung im Viertelpixel-Bereich, Block-Matching kann durch globale Bewegungsschätzung ersetzt werden, Luminanz- und Farbcodierung sind mit frei wählbaren Quantisierungstabellen belegbar

- eigener Objekttyp für Hintergründe, der größer sein kann als das sichtbare Bild und verschoben werden kann

- 17 Parts

- Delivery Multimedia Integration Framework (DMIF): Sitzungs- und Streamingprotokoll, übertragen werden Pointer auf die Inhalte anstatt Download

- Umfang ist so groß, dass er kaum umgesetzt werden konnte → Videokomprimierungsanteil wurde 2003 gemeinsam mit der ITU spezifiziert: H.264/AVC

- Gemeinsamkeiten mit früheren Standards

- Luma-Chroma-Subsampling 4:2:0

- Makroblöcke

- Slices als Sequenz von Makroblöcken

- I-, B-, P-Frames

- Voll- und Halbbildmodus

- Verbesserungen

- Makroblöcke können bis auf 4x4 unterteilt werden

- Bewegungsvektoren mit Viertelpixel-Genauigkeit

- Bewegungsvektoren dürfen über die Bildgrenzen hinausragen

- multiple Referenzbilder für Bewegungsschätzung sind möglich

- Prädiktion in 9 verschiedenen Modi (horizontal, vertikal, diagonal in mehreren Abstufungen)

- Deblocking-Filter reduziert Blockartefakte

- Referenzierung wird von der Reihenfolge der Bilder losgelöst

- gewichtete Mittelung von Referenzblöcken bei bidirektionaler Prädiktion

- Umschalten von Vollbild- und Halbbild-Modus auf Makroblock-Ebene

- örtliche Prädiktion von Blöcken

-

- MPEG1: Video auf CD-ROM, VHS-Qualität, 1,5MBit/s

- MPEG2: TV/HDTV/DVD, Qualitätsprofile, 4-8MBit/s

- MPEG4: universelle Anwendung, objektbasiert, 5kBit/s-4MBit/s

Audiokompression

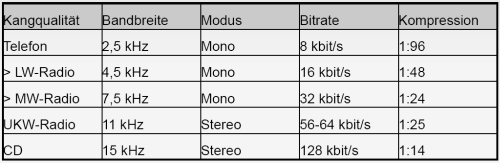

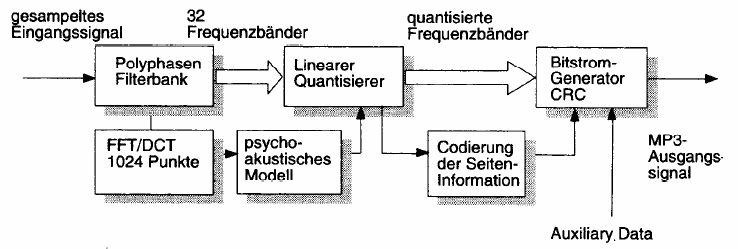

- Audiodaten liegen als zeitdiskreter Bitstrom von Samplingwerten vor → Transformation mittels FFT in den Frequenzraum

- mehrere Samples werden blockweise (Frames) transformiert (bei MP3 Fensterbreite 1152 Samples)

- Filterband teilt das Signal in schmalbandige Frequenzbänder auf

- Maskierungen und die Tatsache, dass Menschen komplexe Schallsignale in Gruppen wahrnehmen, führen zu 24 kritischen Frequenzbändern im Bereich zwischen 16Hz und 16kHz mit ungleicher Breite (ansteigend mit Frequenz)

- MP3 verwendet 32 gleichmäßige Frequenzbänder mit 6 oder 18 möglichen Subbändern (je nach Filterbank)

- die Komprimierung des Signals findet statt, indem die Frequenzbänder durch ein psychoakustisches Modul geschleust werden

- Ermittlung des Leistungsdichtespektrums und der Frequenz des Spitzenpegels im Band → Maskierungsschwelle

- die Maskierungsschwelle wird mit der Ruhehörschwelle verrechnet und heraus kommt die minimale Bitanzahl pro Band, die das Signal (ohne Rauschen über der Hörschwelle) quantisiert

- optimales Subsampling, das das menschliche Ohr nicht wahrnehmen kann

- das Ergebnis geht in die Quantisierung und Codierung der Teilfrequenzbänder ein (Mono und Stereo bis zu 224kbit/s)

- das Verfahren ist stark asymmetrisch (Decodierung ist weniger aufwändig als Codierung)

- Metainformationen: CRC-Checksummen, ID3-Tags

- Stereo-Signale

- Joint Stereo: Mono-Summensignal und Differenzsignale mit Panoramaschwankungen

- Intensity Stereo: verlustbehaftet, untere Frequenzbereiche (Bässe) werden mono-codiert da die Ortung durch das menschliche Ohr schlecht ist

- Dateiaufbau: jeder Frame hat eigenen Header und Prüfsummen → Streaming möglich

- MP3: MPEG1 Layer 3

- 33, 44.1, 48kHz

- 32-224kbit/s

- AAC: bessere Komprimierung und Multikanalunterstützung

- MPEG2 und 4

- 5.1-Kanäle

- geringere Bandbreiten (8kbit/s) und Abtastraten (16kHz) möglich

- vergleichbare Qualität zu MP3 mit 70% der Bitrate

- nicht abwärtskompatibel zu MP3

- Aufteilung des Signals in 1024 Teilbänder und Transformation mittels DCT

- Temporal Noise Shaping (TNS)

- Kompensierung von Quantisierungsfehlern (Rauschen) im Zeitbereich durch Prädiktion insb. bei Sprache

- Verrechnung der Überlappung an den Grenzen der Frequenzbänder

- Rückwärtsprädiktion verringert die Codewortlängen

- Mehrkanalcodierung (M/S): Monosignal und Differenz der Stereomitte in weiteren Kanälen

- Quantisierung durch Gleitkomma-Quantisierung führt zu konstanterem SNR

Dateiformate

Text

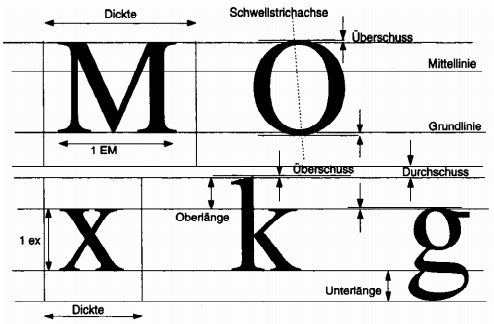

- Typographie: Gestaltungsmuster und -regeln für Schriftdokumente und Ausgestaltung von Schriftarten (Fonts) und Zeichen (Glyphen)

- Zeichensatz: "Übersetzungstabelle" von Symbolen/Textzeichen in Binärwörter

- ASCII: Zeichensatz für englisches Alphabet, Zahlen, Steuerzeichen (1byte)

- Anpassungen für bestimmte Länder mit Sonderzeichen (z.B. Umlaute) z.B. ISO-8859-1 (westeuropäisch), ISO-8859-2 (osteuropäisch)

- Abwandlung durch Microsoft: CP-1252

- Probleme, wenn spezifischer Zeichensatz nicht installiert ist → Zeichen werden falsch angezeigt

- Unicode: Multi-Byte-Zeichensatz, der alle Sprachen der Erde abdecken soll (Unicode 5: 99.089 Zeichen)

- bis zu 4byte wäre nötig, um alle Zeichen zu codieren → Einführung von UTF-8 (8-bit Unicode Transformation Format)

- UTF-8 kann als Multi-Byte-Zeichensatz mit variabler Codewortlänge verstanden werden

- die wichtigsten Zeichen (=ASCII) werden mit 1byte codiert

- sprachspezifische Sonderzeichen werden dann mit 2-4byte codiert

- es sind bis zu 8byte pro Zeichen möglich

- Schriften

- Schriftart: kompletter Satz von Schriftzeichen einer bestimmten Ausgestaltungsform (z.B. Arial, Times)

- Schriftschnitt: Repräsentationsform einer Schriftart (z.B. fett, kursiv)

- Schriftfamilie: Schriftart inkl. Schnitte

- Schriftgruppe: bestimmte Ausgestaltungsform einer Schriftart (z.B. Groteske, Antiqua)

- Serifen: Querstriche an der Grund-, Mittel- und Oberlinie, die dem Auge Halt geben (Grund- und Mittellinie werden betont) und das Lesen längerer Texte vereinfachen

- Schriftdateiformate

- Bitmap: Glyphen sind gerasterte Bilder

- vektorbasiert: Skalierbare Beschreibung der Glyphen durch Stützpunkte, Liniensegmente und Kurvenbeschreibungen

- True Type (TTF): spezifiziert von Adobe, Einsatz in Windows

- Type1 Fonts (Postscript Fonts): spezifiziert von Adobe, besteht aus Klartextdateien (AFM, AMFM, ACFM), werden kompiliert in PFB (binär) oder PFA (ASCII), waren Standard auf Mac

- OpenType (OTF): entwickelt von Adobe und Microsoft, Erweiterung von True Type, kann als Container für Type1 dienen

- LaTeX: Markup-Sprache zur Textgestaltung, Stärke: mathematische Formeln, Trennung von Text und Gestaltung, muss kompiliert werden (z.B. in Postscript, PDF, HTML)

- RTF (Rich Text Format): Austauschformat für Textverarbeitungssysteme, Klartext-ASCII-Dateien ohne Semantik, globale Einstellungen im Kopf der Datei, Befehle werden durch \ eingeleitet, Text durch {} abgetrennt

Bilder

- Rasterbilder

- Aufteilung in rechteckiges Raster, Rasterpunkt = Pixel mit Informationen zur Helligkeit und Farbe

- Auflösung: räumliche Dichte der Pixel in horizontaler und vertikaler Richtung, Einheit dpi (dots per inch)

- Serialisierung zeilenweise von oben links nach unten rechts

- Pixel sind rechteckig (nicht zwangsläufig quadratisch, z.B. bei PAL 1:1,2)

- Skalierung nur durch Interpolation möglich → Verlust der Auflösung

- Bitmap: verlustfreie Speicherung mit/ohne Lauflängencodierung, wird immer zeilenweise gelesen

- Header: Datentyp und Dateigröße

- BITMAP_INFO: Abmessungen des Bildes, Farbtiefe, Codierungsart

- Nutzdaten

- TIFF (Tagged Image File Format)

- spezifiziert 1980 von Aldus, HP, Microsoft

- besteht aus variabler Anzahl von Blöcken, die im Hauptdatenstrom per Zeiger referenziert werden → beliebige Reihenfolge der Nutzdaten

- Blöcke enthalten Tags (12byte) mit Informationen zum Bild (z.B. Höhe, Breite, bit/Pixel)

- keine oder verlustlose Komprimierung möglich: RLE, LZW, Baseline

- wird blockweise gelesen (z.B. nur sichtbarer Bereich bei Bildbearbeitung)

- mehrere Farbsysteme (RGB, CMYK) und Alphakanäle möglich

- TIFF 6.0: Rechte bei Adobe, kann mehrere Bildebenen speichern

- GIF (Graphics Interchange Format): 1987 von UNISYS und Compuserve vorgestellt

- variable Farbtabellen mit Größen der Zweierpotenzen bis 256 (global oder je Rasterblock), Farben aus RGB frei wählbar

- eine Farbe kann als transparent definiert werden, keine Alphakanäle

- seit GIF89a können Animationen als Bildfolgen definiert werden

- Komprimierung mit LZW

- Interlaced-Modus

- bis 2004 lizenzpflichtig

- PNG (Portable Network Graphics Format)

- 48bit pro Pixel → Echtfarbfotos (nur RGB)

- lizenzfrei

- Vorwärtsprädiktion und LZW

- wie GIF: Farbtabellen, Interlaced-Modus, allerdings keine Animationen

- Alphakanäle mit 8/16bit Genauigkeit

- JPEG2000

- anstatt DCT werden Wavelets verwendet

- Nachteile DCT: bei Wertesprüngen werden viele Oberwellen benötigt, Amplituden von Cosinus nähern sich im Unendlichen keinem Grenzwert an

- Verwendung von Hoch- und Tiefpassfiltern und arithmetischer Codierung

- bei vergleichbarer Qualität 30% bessere Kompression als JPEG

- Regions of interest: Bildbereiche, die weniger stark komprimiert werden

- Resync-Marker erlauben Wiederaufnahme unterbrochener Übertragungen

- Artefakte an Blockgrenzen treten nicht so stark hervor

- stufenloser Übergang von verlustfreier zu verlustbehafteter Kompression wird unterstützt

- vektorbasierte Formate

- Grafik als Kombination aus Formen und Flächen (Linien, Kreise, Bezierkurven), Linienfarben und Füllungen mit Farbverläufen möglich

- viele proprietäre Formate

- Austauschformate im Bereich CAD/CAM: IGES (Initial Graphics Exchange Standard), DWF (Drawing Interchange Format)

- SVG (Scalable Vector Graphics)

- XML-Format, 2001 vom W3C spezifiziert

- fehlende Unterstützung im Internet Explorer

- wichtigste grafische Primitive: <path> mit Attribut d für den Pfadverlauf (Großbuchstaben = absolute Angaben, Kleinbuchstaben = relative Angaben)

- m = moveto, l = lineto, q = quadratische Bezierkurve (Stützpunkt, Zielpunkt), c = kubische Bezierkurve (2 Stützpunkte, Zielpunkt), z = Pfad schließen

- Animationen sind möglich (Ableitung von Synchronized Multimedia Integration Language, SMIL)

- Filter wie Gaußscher Weichzeichner sind möglich

- Interaktion durch JavaScript ist möglich

- Postscript

- Seitenbeschreibungssprache von Adobe (1984)

- ist eine eigenständige Programmiersprache

- markiert Wendepunkt in der Digitalisierung des Druckgewerbes

- Container für Text, Grafiken etc.

- wird von einem Interpreter in Rasterdaten umgewandelt (z.B. direkt im Laserdrucker)

- CUPS baut auf Postscript auf

- wird ständig erweitert, kann JPEG verarbeiten, verschiedene Farbräume und Duplexmodi verwalten

- abwärtskompatible ASCII-Dateien

- Einbindung von Postscript-Dateien in DTP: EPS (Encapsulated Postscript), nur eine Seite je Datei möglich, Bounding Box beschreibt Größe

- PDF (Portable Document Format)

- von Adobe 1993 im Zusammenhang mit Acrobat vorgestellt

- Ziel: Vorantreiben des papierlosen Büros durch Bereitstellung eines Formats für digitale Dokumente, Vereinfachung der Druckvorstufe

- proprietäres Format, aber offengelegt und ISO-spezifiziert

- Features in Version 8

- Speicherung als komprimierter Byte-Code

- Aufnahme von Metainformationen

- Einbetten von Schriftarten

- Hypertextkonzepte

- Einbettung beliebiger anderer Dateien

- elektronische Formulare mit interaktiven Formularelementen

- Sicherheitsmechanismen

- digitale Zertifikate und Unterschriften

- Werkzeuge zur Überarbeitung und Korrektur von Dokumenten

Audioformate

- WAV (Wave)

- von IBM und Microsoft entwickelt

- unkomprimiert oder mit verlustloser Kompression

- beginnen mit Format-Chunk (Anzahl Kanäle, Samplingrate etc.)

- danach folgen Datenchunks in PCM oder ADPCM (Adaptive Differential PCM) oder mit Dynamikkompression (a-Law, μ-Law)

- zwischendurch können Fact-Chunks mit Sekundärdaten zum Musikstück oder Cue-Point-Chunks zur Synchronisation eingestreut sein

- AIFF (Audio Interchange Format)

- Verfahren von Apple, gleiches Verfahren wie bei Wave

- kann bis zu 6 Kanäle und MIDI-Chunks aufnehmen

- WAV und AIFF sind gängig bei Produktionen, da keine Generationsverluste auftreten und die Daten unkomprimiert vorliegen

- MP3 und AAC unterliegen Patentschutz

- Ogg: Open-Source-Datenformat für Audio- und Videodaten

- Ogg-FLAC (Free Lossless Audio Codec)

- verlustfreie Kompression bis zu 5:1

- Unterteilung in Blöcke mit bis zu 65536 Samples und Prädiktion aus vier möglichen Modellen

- Speicherung des Fehlers mit Rice-Codes

- umfangreiche Taggingmöglichkeiten

- Ogg-Vorbis

- verlustbehaftet

- 25% bessere Kompression im Vergleich zu MP3

- 256 Audiokanäle

- keine Begrenzung der Datenrate

Videocontainer und -codecs

- AVI und WMV

- Container für Videos unter Windows

- stellen Header und Body bereit

- machen keine Vorgaben für den Codec

- mögliche Codecs

- Cinepak: Keyframes und Differenzbilder, Rate 7:1

- Indeo: von Intel, stark asymmetrisch, Rate 7:1

- Microsoft Video-1: Rate 2:1

- DivX: Hack des Microsoft MPEG4-Codecs, Verwendung zunächst strafrechtlich verfolgt, inzwischen frei von proprietärem Code

- Xvid: ging 2002 durch Zusammenschluss der Programmierer von OpenDivX hervor

- Quicktime

- Multimedia-Framework von Apple (API und Dateiformat)

- kann Audio-, Bild- und Videodateien und Animationen aufnehmen

- hochintegrative Antwort auf Vielzahl verschiedener Codecs

Medienproduktion

- Einsatzzwecke

- Produktion von Hörspielen, Radiobeiträgen

- Musikproduktion

- Vertonung für Film und Fernsehen

Audio

- Mikrofon: wandelt Schallwellen der Luft in elektrische Signale

- dynamische Mikrofone

- umgekehrter Lautsprecher, Membran schwingt, angehängter Magnet bewegt sich in Kupferspule → Induktion

- sehr robust, kompakte Bauform

- durch ihre akustische Trägheit geeignet für Aufnahme lauter Schallereignisse (Trompete, Schlagzeug etc.)

- Frequenzgang mittenbetont

- Kondensatormikrofone

- Schall verändert Abstand zweier metallischer, elektrisch geladener Membranen

- erzeugte Spannung ist sehr gering → Verstärkung nötig → Phantomspeisung 48V

- sehr empfindlich, feinerer Klang als dynamische Mikrofone

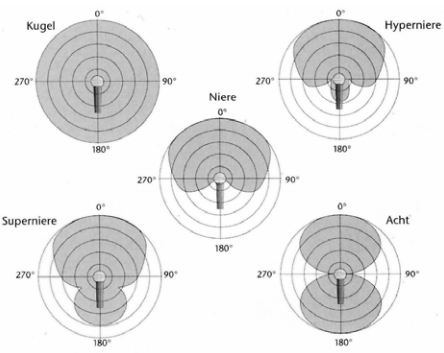

- Richtcharakteristik: Schallempfindlichkeit rings um den Mittelpunkt (die Membran) des Mikrofons

- Mischpult

- zentrale Schaltstelle im Studio, führt mehrere Signalquellen zusammen

- definiert Routen für die Signale, passt Stimmen an, führt Ausgabe den Lautsprechern zu

- es gibt analoge, digitale und virtuelle Mischpulte

- Klassifizierung nach Anzahl Ein-/Ausgänge

- Eingänge

- Line und Mikro (wird stärker verstärkt), Potentiometer regelt jeweilige Verstärkung

- Kanal-Insert: schickt das Signal durch ein Peripheriegerät (Effekte)

- Aux-Weg: schickt mehrere Signale durch Effekte, Anteil des Effekts kann durch Potentiometer gesteuert werden

- Equalizer: 3-4 Bandpassfilter für Verstärkung/Dämpfung einzelner Frequenzbereiche

- Kanalregler: regelt die Signalstärke des Kanals in der Stereosumme

- Subgruppen: ermöglichen Abmischen mehrerer Kanäle (z.B. Schlagzeug) gleichzeitig

- Audiospuren müssen getrennt verwaltet werden können (für weitreichende Klangformung)

- früher wurden Mehrspurgeräte verwendet, heute digitalisierte Speicherung auf Festplatten

- Vorteile der Digitalisierung

- leichter zu verarbeiten und zu handhaben

- Kapazität der Festplatten kann beliebig gesteigert werden

- Anzahl der Aufnahmekanäle ist nur durch eingesetzte Soundkarte begrenzt

- Ausstattungsmerkmale moderner Audiokarten

- mehrere Ein- und Ausgänge

- Analog-Digital-Wandler mit 96kHz und 24bit

- Mikrofoneingänge mit Vorverstärker und Phantomspeisung

- MIDI-Anschluss

- MIDI (Musical Instrument Digital Interface)

- 1981 von Roland eingeführte serielle Schnittstelle zur Steuerung von digitalen Musikinstrumenten (Keyboards, Synthesizer)

- Steuerdaten zur Klangerzeugung und -aufnahme: Anschlag + Tonhöhe, Anschlagsstärke, Tonende, Controllerdaten

- keine Audioinhalte!

- Interface: 5-polige Rundbuchse mit 16 Kanälen

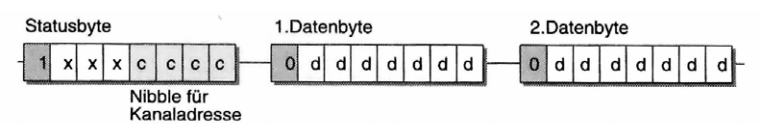

- Daten

- Channel Mode Messages: Steuerung von Musikgeräten

- System Common Messages: Auswertung durch alle Empfänger am Interface

- System Real-Time Messages: Synchronisation der Geräte

- System Exclusive Messages: Hersteller-/Geräte-spezifische Daten (Versionsupdates etc.)

-

- Daten liegen nur eventorientiert (beim Auftritt eines musikalischen Ereignisses) an

- Statusbyte enthält Ereignisart und MIDI-Kanal

- Datenbytes enthalten Werte des Ereignisses (2bytes bei Pitch Bend)

- Synthesizer

- bereits 1900 wurde mit elektrischer Klangerzeugung experimentiert

-

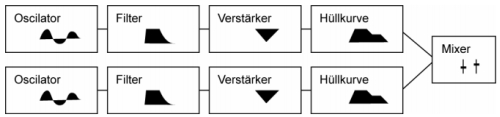

- Oszillator: erzeugt (obertonreiches) kontinuierliches Signal (Wellenform: Sinus, Dreieck, Rechteck, Sägezahn)

- Filter: formt Signal im Frequenzraum (Tiefpass-/Hochpassfilter eliminieren hohe bzw. tiefe Frequenzen)

- Verstärker: passt die Lautstärke an → dynamisches Spiel

- ADSR-Hüllkurve: beschränkt das Signal zeitlich (sonst würden alle Töne unendlich lange gehalten)

- Attack: Zeit vom Anschlag des Tons bis zum vollen Signalpegel des Verstärkers

- Decay: Zeit vom vollen Signalpegel bis zum Sustain (Verweilpegel)

- Sustain: Lautstärkepegel, der nach der Decay-Zeit gehalten werden soll

- Release: Zeit vom Sustain bis zum Nullpegel (Ausklingzeit)

- Mixer: Mischen mehrerer Klangfarben aus der Verarbeitungskette

- Klangeffekte

- Audiomaterial muss gekonnt bearbeitet werden (Abmischung, gleichmäßige Abdeckung des Frequenzspektrums, Effekte)

- Limiter: begrenzt Signal strikt auf eingestellte Lautstärkeschwelle

- Kompressor: nach Überschreiten der Schwelle (Threshold) kann ein Verhältnis (Ratio) angegeben werden, zu dem das Signal abgeschwächt wird

- Abstand zwischen lauten und leisen Tönen wird verringert → kompakterer Klang, geringere Dynamik

- Expander: Dynamik wird entgegengesetzt zum Kompressor erhöht

- Noisegate: unterdrückt Rauschen durch Sperren eines Signals unter einem bestimmten Pegel

- Hall: verleiht Sprache und Musik einen räumlichen Eindruck

- Echo: periodische Widerholung des Signals

- Chorus: doppelt das Signal leicht phasenverschoben und führt zu dichterem Klang

- Verzerrer: bilden das analoge Zerren von übersteuerten Eingangskanälen nach

- Werkzeuge und Software

- Sample-Editoren: Bearbeitung digitaler Audiodateien

- Schneiden, Zusammenfügen der Dateien in Wellenform

- Steinberg Wavelab, Sonic Foundry's Sound Forge

- Sequenzer: Musikproduktion

- Aufzeichnen und Senden von MIDI-Daten

- Einbindung von Synthesizern, Hard-Disk-Recording, Mischen

- Steinberg Cubase, Apple Logic, Digidesign ProTools

- Nachvertonung: Steinberg Nuendo

- Mastering-Software: Tonstudio im Rechner (Effekte, Mehrkanal, Mischen, Mastering)

Foto, Video und DTP

- Desktop Publishing (DTP): Produktion von Druckerzeugnissen (Bücher, Zeitschriften, Flyer etc. vereinen Grafik, Foto und Text) mit Hilfe von Computertechnik

- analoge Kameras

- chemisches Filmmaterial, Entwicklung des Negativs zum Positiv, Kenngröße Lichtempfindlichkeit (ASA)

- Sucherkameras: Sucher getrennt vom Linsensystem → Parallaxe (Versatz) zwischen Sucher und Optik

- Spiegelreflexkameras: Spiegel leiten die Lichtstrahlen der Optik in den Sucher

- Unterscheidung nach

- Kleinformatkameras (24x36mm, 35mm)

- Mittelformatkameras (5x6cm - 6x9cm)

- Großbildkameras (ab 6x9cmd)

- meist für inszenierte Fotografie

- Objektive: wichtig für Qualität der Bilder und die Bildgestaltung

- Normalwinkelobjektive: Brennweite = Diagonale des Filmmaterials, 50-80mm

- Teleoobjektive: enger Aufnahmewinkel, Makrofotografie, großer Zoom, Brennweite > normal

- Weitwinkelobjektive: großer Aufnahmewinkel, Panoramen, große Objekte bei geringem Abstand, Brennweite < normal

- digitale Fotografie

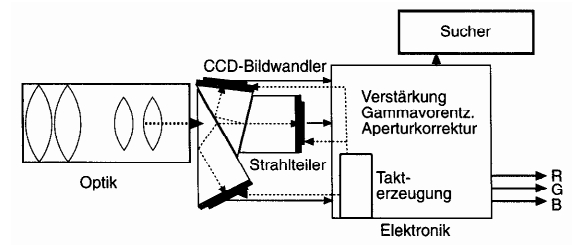

- hier wird kein chemischer Film belichtet, sondern ein optischer Sensor (CCD Charged Coupled Device oder APS Active Pixel Sensor), Speicherung auf Karten, Kenngröße Anzahl lichtempfindlicher Zellen (Auflösung)

- Qualität ist nicht mehr nur von Film und Objektiv abhängig, sondern auch von Auflösung des Chips

- CCD-Chips sind kleiner als übliche Filme, daher muss die Optik sehr gut sein und darauf angepasst

- Vorteile: direkte Verfügbarkeit des Bildes, geringe Kosten pro Bild

- Belichtung

- Blende: steuert die Lichtmenge, die auf den Film/Chip trifft (Durchmesser des Lichtkreises wird angepasst)

- je größer die Blendenzahl, desto kleiner die Öffnung

- die Blende steuert auch die Tiefenschärfe: wird sie geöffnet, werden die Elemente außerhalb der Schärfenebene unscharf

- Belichtungszeit von 1/2000 Sekunde bis zu mehreren Minuten

- um die optimale Kombination aus Blende und Belichtungszeit zu bestimmen, werden Belichtungsmesser (intern oder extern) verwendet

- Bildbearbeitung

- wichtig im professionellen Bereich

- früher Aufgabe des Retuscheurs

- heute: Photoshop oder The Gimp (nicht im professionellen Bereich)

- Größenumrechnung/Interpolation

- Umrechnung in verschiedene Farbsysteme

- Erstellen von Beschneidungspfaden

- Bearbeiten von Alphakanälen

- mehrere Bildebenen und -masken

- Ebeneneffekte und Bildeffekte durch Filter

- DTP

- vektorbasierte Zeichenprogramme: Adobe Illustrator und Freehand

- "echtes" DTP (Adobe InDesign, Quark XPress)

- professioneller Textsatz (Blocksatz, Silbentrennung, Umfluss)

- freie Definition von Druckbögen

- Anlegen von Musterseiten

- Referenzierung von Bildelementen

- "Verpacken" aller Dateien

- Funktionen für die Druckvorstufe (Farbseperation, Überfüllung, Typographie)

- Arbeitsschritte der Druckvorstufe: DTP → Reinzeichnung → Belichtung (4x) → Druck

- Computeranimation: synthetische Erzeugung von Bildern mit dem Computer

- Anwendungsgebiete: Werbung, Trailer, Spezialeffekte in Filmen, Computerspiele

- Ablauf: Modellierung → Reflexionsverhalten/Texturierung → Beleuchtung → Kameradefinition → Animation

- Programme sind sehr komplex mit hoher Lernkurve

- Autodesk 3D Studio Max und Maya, Maxon Cinema 4D, Blender

- Körper werden aus Grundkörpern zusammengesetzt, die verformt werden können

- bei Lebewesen bietet sich die Definition eines digitalen Skeletts an → physikalisch plausible Bewegungen

- Oberflächen können mit Texturen belegt werden und ihre Eigenschaften definiert werden (matt, glänzend, transparent etc.)

- Objekte werden auf einer Bühne positioniert und belichtet (digitale Lichtquellen)

- die Position der Kamera und auch die Blendeneinstellungen (Tiefenschärfe) können dann konfiguriert werden

- Szenen können dann in einer Zeitachse animiert werden

- Videokameras

- professionelle Filmkameras arbeiten auch heute noch analog mit chemischer Belichtung

- Auflösungen: PAL, 720p (1280x720 progressive), 1080i (1920x1080 interlaced)

- Fernseh- und Videokameras arbeiten mit CCD-Chips, können aber die Daten auch analog ausgeben

- günstige Geräte besitzen nur einen Chip, der vor jeder Zelle Filter für Farben hat (1 rot, 1 blau, 2 grün)

- dadurch ist nur ein Viertel der Auflösung des Chips nutzbar → fehlende Information muss interpoliert werden

- hochwertige Kameras besitzen 3 Chips (einen für jede Grundfarbe)

- Vorverarbeitung vor dem Ausgang

- Aperturkorrektur: korrigiert Unschärfen durch Tiefpassfilter um Chip vor ultravioletter Strahlung zu schützen

- Gamma-Vorentzerrung: stellt die Kamerakennlinie ein (Verhältnis zwischen durchschnittlicher Grauwertverteilung am CCD und dem Ausgangssignal), Adaption zur Lichtumgebung

- Weißabgleich: Anpassung an die Farbtemperatur (Sonnenlich 5500 Kelvin, Kunstlicht 3200 Kelvin) der Umgebung

- Bildstabilisatoren: unterdrücken Verwackeln des Bildes bei manueller Kameraführung durch Bewegungserkennung anhand markanter Bildpunkte, die Auflösung des CCD muss hierfür größer sein als der aktive Bildausschnitt

- analoge Aufzeichnungsmedien

- Video-8: FBAS, 8mm

- S-VHS und Hi8: S-Video, höhere Qualität als Video-8

- Betacam SP: 1 Zoll Bandbreite, YUV, qualitativ sehr hochwertig

- digitale Formate

- DV (Konsortium von 60 Herstellern)

- DVCAM (Sony)

- DVCPRO, MiniDV (Standard im digitalen Bereich)

- Digital 8 (Sony)

- Aufzeichnung auf MiniDV-Kassetten (Intraframekompression mit DCT, 25MBit/s)

- HD-Formate

- HDV (Sony und JVC, MPEG2)

- DVCPRO HD (Panasonic, Profisegment)

- AVCHD (Panasonic und Sony, basiert auf AVC aus MPEG4)

- Kameraführung: freihändig, mit Stativ, Steadycam, Kameradolly, Kamerakran

- Videoschnitt

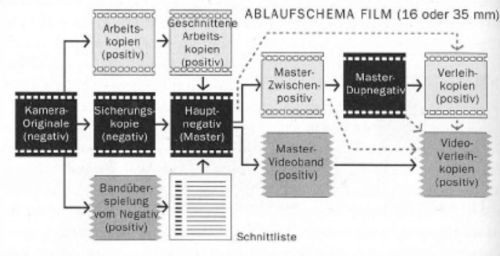

- klassischer Schnitt: Kopien vom Originalnegativ → physikalisches Schneiden → Editor Decision List (EDL) → Kopiermaster (Null-Kopie)

- linearer Schnitt: Kopieren des Films auf eine Masterkopie in linearer Reihenfolge

- nicht-linearer Schnitt: Schnittpunkte werden lediglich referenziert (Cue-Points) → EDL bis zuletzt änderbar

- Onlineschnitt: Schnitt des Orinials

- Offlineschnitt: Schnitt einer Arbeitskopie

- Schnittplatz

- analog: linear offline, mehrere Videor-Player, Video- und Audiomischpult, Effektmodul, Rekorder

- digital: nicht-linear online, Einspielgeräte an Framegrapperhardware (Digitalisierung analoger Signale), Speicherung auf Festplatten, Schnittsoftware

- digitaler Schnitt

- Bereitstellung des Materials: Digitalisieren des benötigten Materials (Bilder, Videos etc.)

- Rohschnitt: grobe Szeneneinteilung

- Komposition: Szenen werden in Zeitleiste montiert, Überblenden und Effekte hinzugefügt

- Feinschnitt: Feinheiten der Blenden und Effekte

- Tonmischung: Originalaufnahmen, Stimmen und Musik werden gemischt

- Produkte: AVID (Hard- und Software), AVID XPress DV, Adobe Premiere, Final Cut Pro

- Postproduction: Auf- und Nachbereitung des rohen Film- oder Videomaterials bis zum Master

- heute nicht nur Schnitt, sondern Einfügen von Effekten, Farbkorrekturen, Kontrastanpassungen, Fehlerkorrektur (Kratzer, Verwacklungen), Audio-Postproduction

- Produkte: Apple Shake, Autodesk Combustion, Adobe AfterEffects

- Compositing: Zusammenstellung von Bildfragmenten unterschiedlicher Herkunft zu einer Szene (Verschmelzen von Real-, Trick- und Animationsfilmsequenzen)

- in-camera: Komposition beim Dreh (Matt-Painting, Rück-/Vorprojektion)

- Integration mittels Keying: bei Chromakey werden Farben als transparent definiert und Schauspieler werden vor Blue-/Greenscreen gefilmt (Alphakanäle möglich)

Internettechnologien

- Internet

- 1960 ARPA-Net (vernetzte Großerchner von Universitäten)

- 1971 E-Mail

- 1989 WWW durch Tim Berners-Lee am CERN: erster Browser und HTML

- URL und DNS

- IP-Adresse identifiziert einen Netzteilnehmer eindeutig

- Ports unterscheiden mehrere Datenströme eines Clients

- IP + Port = Socket

- URI/URL als Adresse zur Verbindungsherstellung mittels TCP/UDP

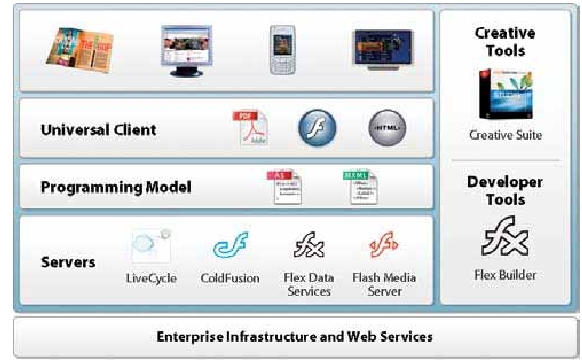

- <Schema>:[<Benutzer>[:<Passwort>]@]<Server-ip|Server-dn>[:Port]/[<Pfad>][?<Parameter-id>=<Parameter-Wert>][&<Parameter-id>=<Parameter-Wert>][#<Fragment>] * DNS bindet IP-Adressen an Namen (Domains) * [Rechnername][<Subdomain>][Domain][TLD] * Domains kennzeichnen einen Verbund von Rechnern in einem Netzwerk (logische Einheit) * Top-Level-Domains: für Länder, Organisationen und Firmen * DNS-Server sind gekoppelt, damit nicht jeder Server alle IP-Adressen und Namen im Internet kennen muss (Relaying) * E-Mail: aus der Not zur Kommunikation heraus entstanden (Ray Tomlinson) * basiert auf drei ASCII-Protokollen * SMTP (Simple Mail Transfer Protocol, Port 25): Versand und Relay von Mails an MTAs (Mail Transfer Agent) * POP (Post Office Protocol, Port 110): Abrufen und Entfernen von Nachrichten von einem Server * IMAP (Internet Message Access Protocol, Port 143): Online-Zugriff auf ein Postfach, Mails verbleiben auf dem Server * HTTP (Hypertext Transfer Protocol, Port 80) * textbasiertes Protokoll zur Kommunikation zwischen Webbrowser und Webserver * GET zur Anfrage einer Seite * Antwort des Servers in der unterstützten Protokollversion mit Statuscode (200 = OK), Metadaten des Servers und der Seite Response-Header und die Seite im Response-Body, Bilder usw. werden danach übertragen * HTTP 1.0: seperate Verbindung für jede Ressource, HTTP 1.1: eine Verbindung reicht * Datenübertragung an den Server: GET (Länge eingeschränkt) und POST (im Request-Body) * zustandslos → Sessions (servergespeichert und Cookies) * WebDAV (Web-based Distributed Authoring and Versioning): Webserver kann auch als Fileserver genutzt werden * FTP (File Transfer Protocol, Port 21) * ASCII-basierts Protokoll zum Austausch von Dateien * unverschlüsselte Übermittlung von Zugangsdaten → SFTP * Hyptertext: in einem Hypertextsystem werden Dokumente, die Teil der Gesamtinformation sind, in Knoten abgelegt und durch Links miteinander verknüpft → semantisches Netz * XML enthält, formt, benennt, strukturiert und schützt Informationen * Markupsprache mit Tags * Tag + Inhalt = Element * Vorteile: Textdateien, universell einsetzbar, frei erweiterbar, einfach zu verstehen * Definition von XML-Strukturen * Document Type Definition: gut für Elementstrukturen und Attributlisten, aber wenig Möglichkeiten zur Kontrolle des Textinhalts * Schema: selbst XML-Dateien mit weitreichenden Kontrollmöglichkeiten * XPath: Abfragesprache für XML ähnlich zu SQL für Datenbanken * boolesche Ausdrücke, Vergleichsoperationen, numerische Operationen, Stringmanipulation * XSLT (Extensible Style Language Transformation): Umwandlung von XML in beliebige andere Formate * Sonderform XSL-FO zur Umwandlung in PDF und Postscript * Beispiele für definierte Formate: DocBook, RelaxNG, MathML * HTML ist die Sprache des WWW und definiert sowohl strukturelle als auch gestalterische Elemente zur Erstellung von Internetseiten * HTML 4.1 lehnt sich nur an XML an, 2001 wurde XHTML spezifiziert, ein valides XML-Format * gute Webseiten nutzen HTML zur Strukturierung der Inhalte und CSS zur Gestaltung * CSS ist eine Technik um die Inhalte von XML-Dokumenten grafisch zu gestalten → Trennung von Inhalt und Layout * Grundlage: Box-Modell mit Margin, Border und Padding * Einbindung per STYLE oder in seperaten Dateien * mittels Selektoren werden Elemente angegeben, die dann über Style-Definitionen formatiert werden sollen * Elemente können IDs und Klassen zugewiesen bekommen * kaskadierbar: mehrere CSS-Dateien pro Dokument, spezialisierte Definitionen überschreiben generische Definitionen * Problem: unterschiedliche Darstellung in den einzelnen Browsern * JavaScript: Skriptsprache, die in den Quelltext von HTML-Seiten eingebunden werden kann * Ausführung auf Client-Seite, wird interpretiert, schwache Typisierung, dynamische Bindung, OO-Konzepte, Einsatz meist für EventHandling * Zugriff auf Funktionen des Webbrowsers, Hilfsobjekte und HTML-Dokument * kein Zugriff auf Ressourcen des Clients (trotzdem Gefahr durch XSS) * Adobe Flash * 1997 von Macromedia veröffentlicht, erstes Programm für vektorbasierte Animationen in Webseiten * Objekte werden auf einer Bühne platziert und animiert, ActionScript wird für das Scripting verwendet * ActionScript 2.0 und Flash MX 2004 in 2003 → OO-Konzepte * 2005 Übernahme durch Adobe * Autorenwerkzeug: Zeitleiste, Bühne, Bibliothek (vektorbasierte Objekte, Filme, Bilder etc.) * wichtigste Objekte: Instanzen der Klasse MovieClip → Container für beliebige in Flash adressierbare Elemente * stellen Attribute und Methoden für Skalierung, Manipulation der Zeitleiste, Bewegung usw. möglich sind * ein Film muss nicht stringent der Zeitleiste folgen, sondern kann durch ActionScript geloopt, gestoppt, fortgesetzt werden * prinzipiell kann jedes aktive Element ActionScript aufnehmen * Vorteile von ActionScript 2.0 * durchgängig objektorientiertes Konzept * Vererbung, Polymorphismus, Interfaces * Klassen können in eigenen Klassendateien verwaltet und wiederverwendet werden * Bibliotheksobjekte lassen sich mit Klassen verknüpfen → Trennung Design/Code * Event-Handler Factory-Klassen (MovieLoader) setzen bekannte Patterns der OOP um * Verbreitungsgrad des Plugins 85%-95% * "echte" Multimedia-Webseiten können erzeugt werden * Nachladen von Bildern, Animationen, XML-Anbindung an Middleware, Audioeinbettung * Flash-Video-Forma FLV ist proprietär und nicht offengelegt, hohe Verbreitung durch YouTube * 2004 erste Version von Flex als integriertes Werkzeug zur Erstellung von Multimedia-fähigen Oberflächen für Websites * Flex-Builder: IDE für Multimedia-Frontends (Eclipse-Plugin) * große Klassenbibliothek für Datenein- und -ausgabe und Layoutgestaltung * Layout wird mit MXML-Dateien realisiert * Kommunikation zum Server mittels WebServices * Flex Data-Services ermöglicht weitere Anbindung über RPC, JMS, EJB und ColdFusion, Java-Anwendung, die z.B. im Tomcat deployt werden kann, sehr teuer *

* Flash dient zur Erstellung von RIA mit Animation, Sound, Video

* trotz großer Verbreitung geringere Client-Unterstützung als AJAX

===== Serverseitige Technologien =====

* CGI (Common Gateway Interface): Mechanismus zum Aufruf externer Programme durch HTML-Seiten

* einfaches Deployment durch interpretierte schwach-typisierte Sprachen: Perl (Practical Extraction and Report Language), PHP, Python, Ruby

* Java

* Entwicklung durch Sun Microsystems mit Ziel der Plattformunabhängigkeit, seit 2007 OpenSource

* Java lehnt sich an C++ an, aber

* keine Mehrfachvererbung

* Garbage-Collector anstatt Destruktoren

* keine Pointer

* Java-Code wird in Bytecode übersetzt, der auf der Laufzeitumgebung (JRE) läuft

* Applets: kleine Java-Applikationen auf dem Webserver, die in der JRE des Clients in einer Sandbox laufen, heute kaum noch relevant

* Servlet-API und JSP

* Servlets verarbeiten HTTP-Requests und -Responses

* JSP vereinfachen die Arbeit mit HTML: hier wird Code in HTML eingebettet

* benötigt Servlet-Container wie Apache Tomcat

* J2EE enthält Komponenten und Bibliotheken um mehrschichtige, datenbank- und transaktionsgestützte Webanwendungen zu entwickeln

* Skalierbarkeit, Performance, Interoperabilität

* benötigt einen Application Server mit den folgenden Komponenten

* EJB: Geschäftslogik (Session-, Entity- und Message-Driven-Beans)

* Servlets / JSP: HTML-Fassade für die Clients

* JSF: baut auf JSP auf und ermöglicht den Einsatz von kompletten Komponenten zur Datenein- und -ausgabe und Navigationsregeln mittels XML, Daten werden von Managed-Beans verwaltet

* JNDI: Schnittstelle für Anwendungen zur Nutzung beliebiger Datencontainer

* JMS: API für asynchrone Nachrichtenverarbeitung

* JDBC: API für relationalen Datenbankzugriff

* JTA: Transaktionsmanagement

* JPA: einfache Erstellung von Entity-Beans und Datenbankanbindung

* Java Mail: Schnittstelle für Mailverarbeitung

* insbesondere bei großen Webapplikationen im Einsatz

* Nachteil ist die starre Vorgabe von Richtlinien für die Beans etc. → Overhead

* Reaktion von Sun in EJB 3.0 und Java EE 5.0: Annotationen kennzeichnen Klassen (z.B. Persistenz und WebServices)

* Vorteile: Daten sind in der Klasse selbst definiert, Compiler kann Fehler erkennen

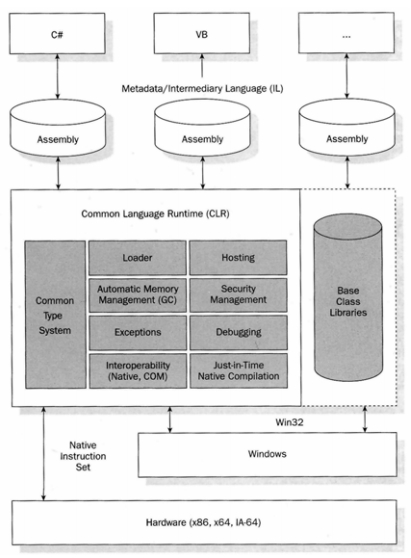

* .NET-Framework

* erste Ansätze durch ASP → Einbettung von VisualBasic in HTML, Auswertung durch IIS

* ASP reichte schnell nicht mehr aus → .NET-Framework

* Laufzeitumgebung CLR: verschiedene Programmiersprachen möglich (VB, C++, C#), Übersetzung in Intermediate Language (IL), die dann ausgeführt wird

*

* Flash dient zur Erstellung von RIA mit Animation, Sound, Video

* trotz großer Verbreitung geringere Client-Unterstützung als AJAX

===== Serverseitige Technologien =====

* CGI (Common Gateway Interface): Mechanismus zum Aufruf externer Programme durch HTML-Seiten

* einfaches Deployment durch interpretierte schwach-typisierte Sprachen: Perl (Practical Extraction and Report Language), PHP, Python, Ruby

* Java

* Entwicklung durch Sun Microsystems mit Ziel der Plattformunabhängigkeit, seit 2007 OpenSource

* Java lehnt sich an C++ an, aber

* keine Mehrfachvererbung

* Garbage-Collector anstatt Destruktoren

* keine Pointer

* Java-Code wird in Bytecode übersetzt, der auf der Laufzeitumgebung (JRE) läuft

* Applets: kleine Java-Applikationen auf dem Webserver, die in der JRE des Clients in einer Sandbox laufen, heute kaum noch relevant

* Servlet-API und JSP

* Servlets verarbeiten HTTP-Requests und -Responses

* JSP vereinfachen die Arbeit mit HTML: hier wird Code in HTML eingebettet

* benötigt Servlet-Container wie Apache Tomcat

* J2EE enthält Komponenten und Bibliotheken um mehrschichtige, datenbank- und transaktionsgestützte Webanwendungen zu entwickeln

* Skalierbarkeit, Performance, Interoperabilität

* benötigt einen Application Server mit den folgenden Komponenten

* EJB: Geschäftslogik (Session-, Entity- und Message-Driven-Beans)

* Servlets / JSP: HTML-Fassade für die Clients

* JSF: baut auf JSP auf und ermöglicht den Einsatz von kompletten Komponenten zur Datenein- und -ausgabe und Navigationsregeln mittels XML, Daten werden von Managed-Beans verwaltet

* JNDI: Schnittstelle für Anwendungen zur Nutzung beliebiger Datencontainer

* JMS: API für asynchrone Nachrichtenverarbeitung

* JDBC: API für relationalen Datenbankzugriff

* JTA: Transaktionsmanagement

* JPA: einfache Erstellung von Entity-Beans und Datenbankanbindung

* Java Mail: Schnittstelle für Mailverarbeitung

* insbesondere bei großen Webapplikationen im Einsatz

* Nachteil ist die starre Vorgabe von Richtlinien für die Beans etc. → Overhead

* Reaktion von Sun in EJB 3.0 und Java EE 5.0: Annotationen kennzeichnen Klassen (z.B. Persistenz und WebServices)

* Vorteile: Daten sind in der Klasse selbst definiert, Compiler kann Fehler erkennen

* .NET-Framework

* erste Ansätze durch ASP → Einbettung von VisualBasic in HTML, Auswertung durch IIS

* ASP reichte schnell nicht mehr aus → .NET-Framework

* Laufzeitumgebung CLR: verschiedene Programmiersprachen möglich (VB, C++, C#), Übersetzung in Intermediate Language (IL), die dann ausgeführt wird

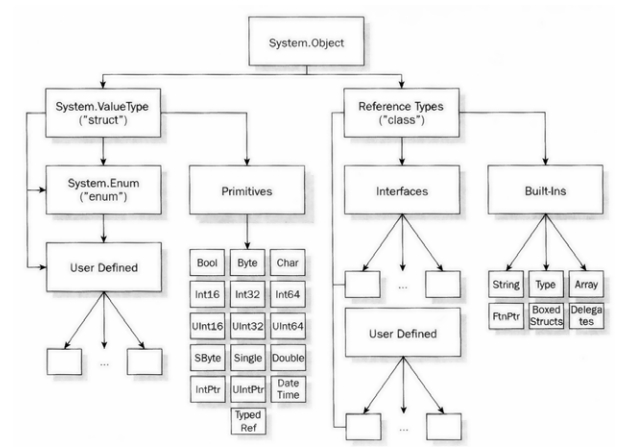

*  * Common Type System als Datentyp-Grundlage für alle Programmiersprachen

*

* Common Type System als Datentyp-Grundlage für alle Programmiersprachen

*  * Features: Exception-Handling, Garbage-Collector, JIT, Sicherheitsmechanismen, umfangreiche Klassenbibliothek, Reflection, Generics

* Performance liegt zwangsläufig unter nativem Maschinencode

* Einsatz für mehrschichtige Webanwendungen

* ADO.NET für DB-Zugriff, Logik in DLLs, Präsentation durch ASP.NET

* Datenabstraktion durch LINQ

* WPF: Framework für die Erstellung von Anwendungsoberflächen und Darstellung multimedialer Inhalte

* 2D und 3D Rendering Engine

* XAML (Extensible Application Markup Language) zur Beschreibung der Oberflächen → Trennung Design und Logik

* Silverlight

* Ruby on Rails

* Ruby: schwach typisierte OO-Skriptsprache

* Rails: Webframework

* convention over configuration, don't repeat yourself

* Prinzipien: semantische Dateistruktur, Active Records, Scaffolding, offene Architektur, AJAX integriert

===== Web 2.0 =====

* RSS/Atom: XML-Format für Neuigkeiten auf Webseiten

* Schema für XML-Dateien

* Einbindung über LINK in HTML-Seiten

* Podcasts: Neologismus aus iPod und Broadcast

* Basis ist RSS

* MP3s werden per RSS verteilt

* normale Nutzer können "ihr eigenes Radioprogramm erstellen"

* Vorteil: asynchrones Anhören der Inhalte nach Download

* Blogs: Abkürzung für Weblog

* Massenphänomen dank einfacher Software (CMS)

* Wikis

* Benutzer erstellen Inhalte gleichberechtigt

* setzen sich auch in Unternehmen durch (Kundenbindung, Marketing)

* Problem: Qualitätssicherung

* Folksonomy

* AJAX (Asynchronous JavaScript and XML)

* durchbricht das bisherige Paradigma der Webseiten durch dynamisches Laden von Teilbereichen der Seiten

* Kommunikation mit Server über XMLHttpRequest-Objekt

* Beispiele: Google Mail, Yahoo

* Möglichkeiten: Drag-and-Drop, Online-Anwendungen wie Office, Eingabevalidierung on-the-fly

* Benutzer braucht kein Plugin (nur JavaScript)

* Probleme

* Unterstützung durch die verschiedenen Browser (insb. IE)

* Browser-Buttons funktionieren nicht mehr

* Lesezeichen können nicht genutzt werden

* höherer Traffic

* Debugging ist schwierig

* Mashups: Vernetzung von Komponenten verschiedener Herkunft in einem Angebot (Content-Syndication)

* Beispiele: Google Maps, Videoportale, Yahoo Pipes

* Web 2.0: keine Technologie, sondern der Wandel der Rezeption und Produktion multimedialer Inhalte im Internet

* Grenze zwischen Produzent und Konsument weicht auf

* Content wird von den Benutzern erstellt

* Anwendungen verlagern sich auf Webserver

* Probleme: Datenschutz, Sicherheit, Kriminalität, Medienkompetenz ist nötig

===== Virtual Reality =====

* dem Benutzer wird ein Modell der Welt dargeboten, das der Benutzer beeinflussen kann

* Kennzeichen

* Interaktivität: Einwirken auf die künstliche Welt

* Gleichzeitigkeit: unmittelbare Reaktion der künstlichen Welt

* Immersion: Verschmelzen mit der künstlichen Welt

* Einsatzgebiete

* Computerspiele

* Medizintechnik

* Produktdesign

* die Immersion erfordert neue Eingabemöglichkeiten (HCI, Human Computer Interface)

* neue physikalische und biologische Sensoren

* Datenhandschuh

* Monitorbrille (Head Mounted Display)

* Lagesensoren

* Tracking-Systeme

* VRML (Virtual Reality Modeling Language)

* 1994 erschienen, 1996 kam Version 2 und VRML Konsortium wurde gegründet

* ASCII-basierte Sprache zur Beschreibung von 3D-Objekten

* wird vom Browser interpretiert

* plattformunabhängig

* kann Animationen, Videos, Bilder, Klänge beinhalten

* ermöglicht Benutzerinteraktion

* Probleme: Browserkompatibilität, langsam

* Beschreibung der virtuellen Welt durch einen Szenegraph in Baumstruktur mit verschiedenen Knotentypen

* Geometrikknoten für geometrische Formen

* Interpolatoren für zeitliche Veränderungen

* Sensoren generieren benutzer- oder zeitgesteuert Ereignisse

* Umgebungsknoten für Lichtquellen, Audio etc.

* Ansichtknoten für Navigations- und Kamerainformationen

* Scriptknoten steuern Ereignisse per JavaScript

* Unterschied zu 3D-Programmen: VRML wird nicht gerendert, sondern zur Laufzeit dargestellt

* 2003 wurde X3D eingeführt, das VRML in ein XML-Format überführt

===== Links =====

* Zusammenhang zwischen sone und phon

* Farbunterabtastung

===== ToDo =====

* Unterscheidung BAS / FBAS

* LZW und Huffman im Baum durchspielen

* logarithmische und 3-Step-Suche am Beispiel durchführen

* Unterschiede zwischen wichtigen Themen herausarbeiten

* Flash und ActionScript anschauen

==== Alte Klausur ====

* Definitionen: GOP, XML, XSLT

* Huffman und LZW anwenden

* Vorteile des AVC

* ActionScript-Ausschnitte erklären

* JPEG erklären

* Unterschied AJAX / Servlet/Applet

* CSS Box Model

* Shannon-Nyquist-Theorem anwenden

===== Klausur =====

* Gegenüberstellungen

* Zusammenhänge

* Detailfragen

* Flash-Codeausschnitte kommentieren

* Hilfsmittel: Taschenrechner

* Skype: maddias.r

===== Begriffe =====

* Determiniertheit

* Ein Algorithmus ist eine eindeutige Abbildung.

* Determinismus

* Zu jedem Zeitpunkt ist der nachfolgende Abarbeitungsschritt eines Algorithmus eindeutig festgelegt.

* Kontinuität (analoge Signale)

* lückenloser Zusammenhang, Stetigkeit, stetige Werte

* Diskretheit

* räumliche oder zeitliche Trennung von Objekten oder Ereignissen

* Periode = Schwingungsdauer T

* Eine Periode ist die kleinste Zeitdauer einer sich wiederholenden physikalischen Erscheinung.

* Frequenz f

* Kehrwert der Periode

* harmonische Schwingung

* Zeitabhängigkeit der veränderlichen Zustandsgrößen ist sinusförmig.

* t und F sind unabhängig von Amplitude.

* Konvergenz <> Divergenz

* Existenz eines Grenzwertes bei einer Folge

* Fraktal

* Gebilde mit hoher Selbstähnlichkeit (Beispiel: Mandelbrot-Menge)

* Korrelation

* Beziehung zwischen zwei oder mehr statistischen Variablen (nicht zwingend kausal).

===== ToRead =====

* DIN 33401

* Features: Exception-Handling, Garbage-Collector, JIT, Sicherheitsmechanismen, umfangreiche Klassenbibliothek, Reflection, Generics

* Performance liegt zwangsläufig unter nativem Maschinencode

* Einsatz für mehrschichtige Webanwendungen

* ADO.NET für DB-Zugriff, Logik in DLLs, Präsentation durch ASP.NET

* Datenabstraktion durch LINQ

* WPF: Framework für die Erstellung von Anwendungsoberflächen und Darstellung multimedialer Inhalte

* 2D und 3D Rendering Engine

* XAML (Extensible Application Markup Language) zur Beschreibung der Oberflächen → Trennung Design und Logik

* Silverlight

* Ruby on Rails

* Ruby: schwach typisierte OO-Skriptsprache

* Rails: Webframework

* convention over configuration, don't repeat yourself

* Prinzipien: semantische Dateistruktur, Active Records, Scaffolding, offene Architektur, AJAX integriert

===== Web 2.0 =====

* RSS/Atom: XML-Format für Neuigkeiten auf Webseiten

* Schema für XML-Dateien

* Einbindung über LINK in HTML-Seiten

* Podcasts: Neologismus aus iPod und Broadcast

* Basis ist RSS

* MP3s werden per RSS verteilt

* normale Nutzer können "ihr eigenes Radioprogramm erstellen"

* Vorteil: asynchrones Anhören der Inhalte nach Download

* Blogs: Abkürzung für Weblog

* Massenphänomen dank einfacher Software (CMS)

* Wikis

* Benutzer erstellen Inhalte gleichberechtigt

* setzen sich auch in Unternehmen durch (Kundenbindung, Marketing)

* Problem: Qualitätssicherung

* Folksonomy

* AJAX (Asynchronous JavaScript and XML)

* durchbricht das bisherige Paradigma der Webseiten durch dynamisches Laden von Teilbereichen der Seiten

* Kommunikation mit Server über XMLHttpRequest-Objekt

* Beispiele: Google Mail, Yahoo

* Möglichkeiten: Drag-and-Drop, Online-Anwendungen wie Office, Eingabevalidierung on-the-fly

* Benutzer braucht kein Plugin (nur JavaScript)

* Probleme

* Unterstützung durch die verschiedenen Browser (insb. IE)

* Browser-Buttons funktionieren nicht mehr

* Lesezeichen können nicht genutzt werden

* höherer Traffic

* Debugging ist schwierig

* Mashups: Vernetzung von Komponenten verschiedener Herkunft in einem Angebot (Content-Syndication)

* Beispiele: Google Maps, Videoportale, Yahoo Pipes

* Web 2.0: keine Technologie, sondern der Wandel der Rezeption und Produktion multimedialer Inhalte im Internet

* Grenze zwischen Produzent und Konsument weicht auf

* Content wird von den Benutzern erstellt

* Anwendungen verlagern sich auf Webserver

* Probleme: Datenschutz, Sicherheit, Kriminalität, Medienkompetenz ist nötig

===== Virtual Reality =====

* dem Benutzer wird ein Modell der Welt dargeboten, das der Benutzer beeinflussen kann

* Kennzeichen

* Interaktivität: Einwirken auf die künstliche Welt

* Gleichzeitigkeit: unmittelbare Reaktion der künstlichen Welt

* Immersion: Verschmelzen mit der künstlichen Welt

* Einsatzgebiete

* Computerspiele

* Medizintechnik

* Produktdesign

* die Immersion erfordert neue Eingabemöglichkeiten (HCI, Human Computer Interface)

* neue physikalische und biologische Sensoren

* Datenhandschuh

* Monitorbrille (Head Mounted Display)

* Lagesensoren

* Tracking-Systeme

* VRML (Virtual Reality Modeling Language)

* 1994 erschienen, 1996 kam Version 2 und VRML Konsortium wurde gegründet

* ASCII-basierte Sprache zur Beschreibung von 3D-Objekten

* wird vom Browser interpretiert

* plattformunabhängig

* kann Animationen, Videos, Bilder, Klänge beinhalten

* ermöglicht Benutzerinteraktion

* Probleme: Browserkompatibilität, langsam

* Beschreibung der virtuellen Welt durch einen Szenegraph in Baumstruktur mit verschiedenen Knotentypen

* Geometrikknoten für geometrische Formen

* Interpolatoren für zeitliche Veränderungen

* Sensoren generieren benutzer- oder zeitgesteuert Ereignisse

* Umgebungsknoten für Lichtquellen, Audio etc.

* Ansichtknoten für Navigations- und Kamerainformationen

* Scriptknoten steuern Ereignisse per JavaScript

* Unterschied zu 3D-Programmen: VRML wird nicht gerendert, sondern zur Laufzeit dargestellt

* 2003 wurde X3D eingeführt, das VRML in ein XML-Format überführt

===== Links =====

* Zusammenhang zwischen sone und phon

* Farbunterabtastung

===== ToDo =====

* Unterscheidung BAS / FBAS

* LZW und Huffman im Baum durchspielen

* logarithmische und 3-Step-Suche am Beispiel durchführen

* Unterschiede zwischen wichtigen Themen herausarbeiten

* Flash und ActionScript anschauen

==== Alte Klausur ====

* Definitionen: GOP, XML, XSLT

* Huffman und LZW anwenden

* Vorteile des AVC

* ActionScript-Ausschnitte erklären

* JPEG erklären

* Unterschied AJAX / Servlet/Applet

* CSS Box Model

* Shannon-Nyquist-Theorem anwenden

===== Klausur =====

* Gegenüberstellungen

* Zusammenhänge

* Detailfragen

* Flash-Codeausschnitte kommentieren

* Hilfsmittel: Taschenrechner

* Skype: maddias.r

===== Begriffe =====

* Determiniertheit

* Ein Algorithmus ist eine eindeutige Abbildung.

* Determinismus

* Zu jedem Zeitpunkt ist der nachfolgende Abarbeitungsschritt eines Algorithmus eindeutig festgelegt.

* Kontinuität (analoge Signale)

* lückenloser Zusammenhang, Stetigkeit, stetige Werte

* Diskretheit

* räumliche oder zeitliche Trennung von Objekten oder Ereignissen

* Periode = Schwingungsdauer T

* Eine Periode ist die kleinste Zeitdauer einer sich wiederholenden physikalischen Erscheinung.

* Frequenz f

* Kehrwert der Periode

* harmonische Schwingung

* Zeitabhängigkeit der veränderlichen Zustandsgrößen ist sinusförmig.

* t und F sind unabhängig von Amplitude.

* Konvergenz <> Divergenz

* Existenz eines Grenzwertes bei einer Folge

* Fraktal

* Gebilde mit hoher Selbstähnlichkeit (Beispiel: Mandelbrot-Menge)

* Korrelation

* Beziehung zwischen zwei oder mehr statistischen Variablen (nicht zwingend kausal).

===== ToRead =====

* DIN 33401

se/multimedia.txt · Zuletzt geändert: 2014-04-05 11:42 (Externe Bearbeitung)